Niemals darf KI sich zwischen uns und unser Verständnis stellen

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Kasparov, Jennings, Hui, Sedol und Jie. Fünf Namen und Biographien, die eng mit der Geschichte der Künstlichen Intelligenz verwoben sind. Alle zogen siegessicher in die Schlacht, hatten aber schon zur Halbzeit keine Chance mehr. Sie wurden brutal durch Rechengewalt in die Knie gezwungen oder von einer außerirdischen nicht-empfindungsfähigen Intelligenz überlistet. Die Moral der Geschichte: Künstliche Intelligenz dürfen sich nie zwischen uns und unser Verständnis stellen. Wir dürfen uns nicht von Black Boxes abhängig machen. KI ist maximal eine Aktivierungsschicht, die uns hilft spezifische Probleme besser zu verstehen.

Im siebten Zug des entscheidenden Spiels machte Schwarz einen kritischen Fehler. Weiß nutzte den Vorteil, opferte einen Springer und schuf einen neuen Angriff. Elf Züge später hatte Weiß eine dermaßen starke Position aufgebaut, dass Schwarz sich die Niederlage eingestehen musste. Der Verlierer reagierte entrüstet und warf Weiß Betrug vor. Ein Vorwurf, der 22 Jahre später noch im Raum steht. Es ist nicht ungewöhnlich, dass der Verlierer den Gewinner des Betrugs beschuldigt. Aber in diesem Fall hieß der Verlierer Garry Kasparov und der Sieger war ein Computer namens IBM Deep Blue.

Abbildung 1: Garry Kasparov, 1985, Wikimedia

Abbildung 1: Garry Kasparov, 1985, Wikimedia

Garry Kasparov wurde mit einem gesunden Selbstvertrauen geboren. Er hatte im Leben eines Schachspielers alles erreicht und seinen Sport über Jahre dominiert. Mit 17 bekam er den Titel eines Großmeisters verliehen und im selben Jahr gewann er in Dortmund die Junioren-Weltmeisterschaft. Sechs Jahre später wurde er offizieller Weltmeister des Weltschachbundes FIDE und behielt den Titel bis ins Jahr 2000.

In seiner Karriere trat er mehrmals unter Wettkampfbedingungen gegen Schachprogramme an. In den 1980er Jahren hatte er behauptet, er werde niemals von einem Schachprogramm besiegt werden. Und so spielte er voller Selbstsicherheit 1989 gegen den von IBM gebauten Supercomputer Deep Thought zwei Partien, die er beide gewann. Sieben Jahre später besiegte Kasparow in Philadelphia dessen Nachfolger Deep Blue in einem Match über sechs Partien mit 4:2, verlor mit der 1. Wettkampfpartie aber als erster Schachweltmeister überhaupt gegen einen Computer. Immerhin stand Deep Blue auf der Rangliste der mächtigsten Computer der Welt auf Platz 259 und war ausschließlich mit Schachspielen beschäftigt.

Kasparov war sich sicher, dass er 15 Monate später im Rückspiel in New York gegen Deep Blue bestehen und siegreich aus der Partie heraus gehen würde. Doch es kam alles anders. Am 11. Mai 1997 unterlag er in der entscheidenden sechsten Partie und verlor den Wettkampf mit 2,5:3,5.

Auf den Videoaufnahmen ist Kasparow die Verzweiflung und Hilflosigkeit anzusehen. Nach knapp vier Minuten gibt er auf. Deep Blue, der 200 Millionen Stellungen pro Sekunde berechnen oder bis zu 40 oder mehr Züge in die Zukunft “sehen” konnte, war ein zu starker, zu emotionsloser, zu logischer Gegner. Deep Blue, die geistreiche Erfindung von Feng-Hsiung Hsu, hat Kasparov mit einfachen Regeln, effizienten Taktiken und mathematischer roher Gewalt in die Knie gezwungen.

Abbildung 2: Sechstes und letztes Spiel im Rematch zwischen Schachweltmeister Garry Kasparov und IBM-Supercomputer Deep Blue, New York, 1997

Abbildung 2: Sechstes und letztes Spiel im Rematch zwischen Schachweltmeister Garry Kasparov und IBM-Supercomputer Deep Blue, New York, 1997

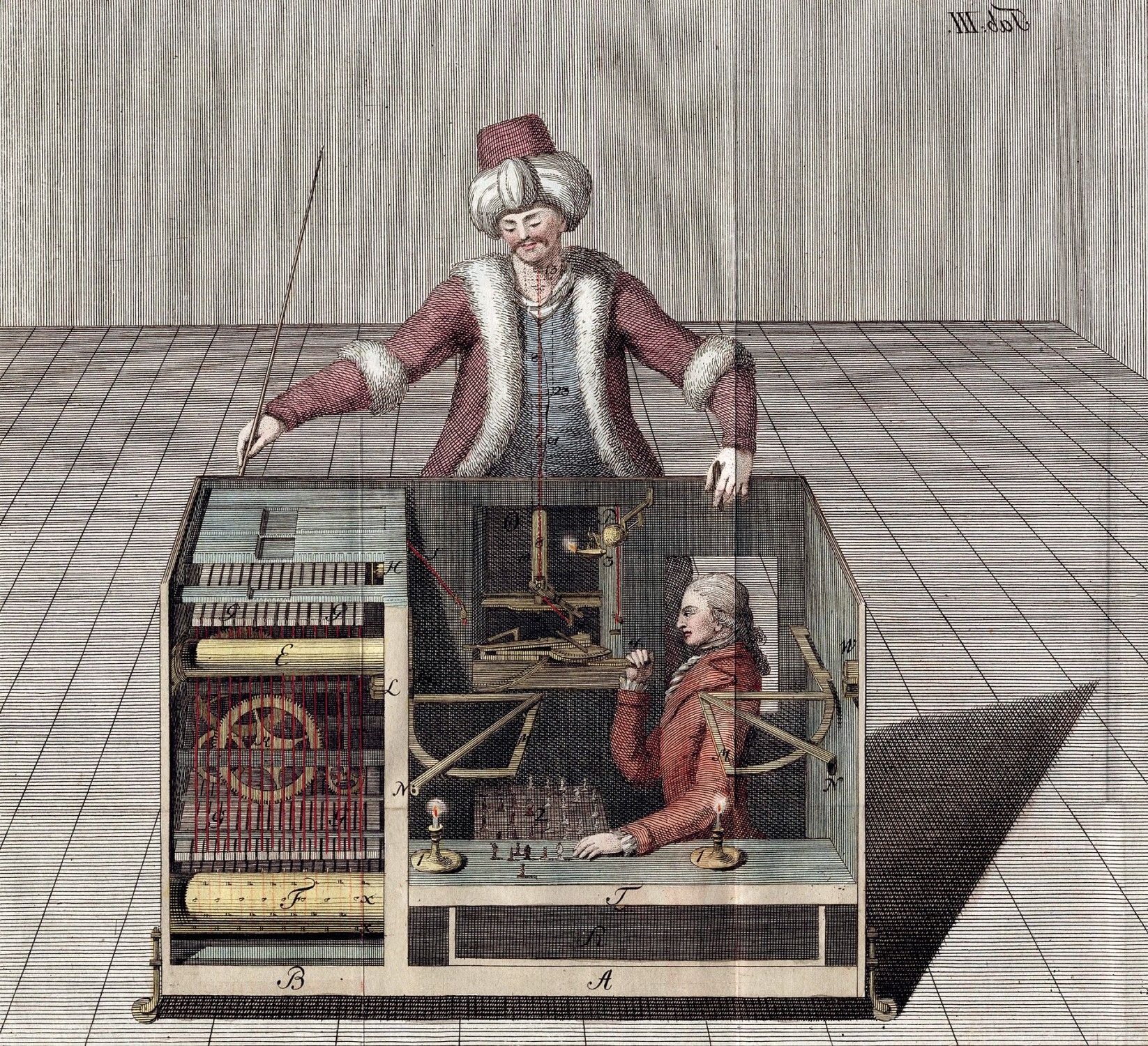

Nach dem Spiel war Kasparov frustriert und uneinsichtig. Er beschuldigte das Deep Blue-Team, dem Computer geholfen zu haben. Er behauptete, dass einige der Züge so intelligent und kreativ gewesen seien, dass nur Menschen dahinter stecken können. Er war der Überzeugung, dass eine moderne Version des Schachtürken ihn geschlagen hätte. Doch wie die Geschichte zeigte, stellte sich der Vorwurf und die vielen Verschwörungstheorien als haltlos heraus. Kasparov verlor, weil er menschliche Züge zeigte und zu viel in die Züge der Maschine hineininterpretierte.

Viele Jahre später zeigte Kasparov sich geläutert: “While writing my book I did a lot of research — analyzing the games with modern computers, also soul-searching — and I changed my conclusions. I am not writing any love letters to IBM, but my respect for the Deep Blue team went up, and my opinion of my own play, and Deep Blue’s play, went down. Today you can buy a chess engine for your laptop that will beat Deep Blue quite easily.“

In der Folge kanalisierte er seine Frustration in der Suche nach einem Weg, um das Schachspiel vor der Dominanz der Maschinen zu retten. Er erkannte etwas, das KI-Forscher das Moravec’sche Paradox nennen. Maschinen und Menschen haben gegensätzliche Stärken und Schwächen. Moravec schreibt:

„Es ist vergleichsweise einfach, Computer dazu zu bringen, Leistungen auf Erwachsenenniveau bei Intelligenztests oder beim Dame spielen zu erbringen, und schwierig oder unmöglich, ihnen die Fähigkeiten eines Einjährigen in Bezug auf Wahrnehmung und Mobilität zu vermitteln.“

Ein Sprichwort besagt, dass Schach zu 99 Prozent Taktik ist. Taktiken sind Zugkombinationen, mit denen man einen Vorteil auf dem Brett erzielen kann. Wenn man diese Taktiken studiert (so wie es Deep Thought mit der Karriere von Kasparov getan hat), beherrscht man die Taktiken und gewinnt die ersten Schlachten. Sich dann zu fragen, warum der Zug schlecht war, kann dabei helfen, die Taktik zu verbessern. Sich aber zu fragen, warum man den Zug unter den herrschenden Umständen gewählt hat, hilft, die Strategie künftig anzupassen. Und wie wir alle wissen, gewinnt man Kriege nur mit einer guten Strategie.

Computer sind im Vergleich zu Menschen Taktikkönige. Aufgrund ihrer Rechenleistung und Effizienz sind sie in der Lage, Muster in Millisekunden zu erkennen und dementsprechend zu reagieren. In gewisser Weise funktionieren die Gehirne von Schachgroßmeistern ähnlich. Die meisten Großmeister haben kein „photographisches Gedächtnis“. Sie erinnern sich eher an Situationen, an Spielgruppen beziehungsweise an Muster aus ihrer Vergangenheit. Basierend auf ihrer Erfahrung, können sie in wenigen Sekunden die Situation einschätzen und den nächsten Zug planen.

Abbildung 3: Der Schachtürke, Wikimedia

Abbildung 3: Der Schachtürke, Wikimedia

Mit dem Siegeszug der Computer wurden die Taktik-Kenntnisse der Schachgroßmeister egalisiert. Sie wurden ausgelagert. Damit verlagerte sich der Fokus von der Taktik zur Strategie. Kasparov stellte in der Zeit fest, dass der Mensch nur eine Chance gegen Maschinen haben wird, wenn er seine Kreativität in den Vordergrund stellen wird. Er fragte sich fortan, was passieren würde, wenn man die taktischen Fähigkeiten der Computer mit dem großformatigen Denken der Menschen kombinieren würde.

1998 fand das von Kasparov ins Leben gerufene erste “Advanced Chess”-Turnier statt, bei dem jeder menschliche Spieler, darunter Kasparov selbst, mit einem Computerprogramm zusammenarbeitete. In der Folge entwickelte sich eine weitere Spielart namens „Freestyle Chess“, die weniger restriktiv war und das Spielen in Teams erlaubte. So konnte ein Duo von Amateurspielern mit drei Computern 2014 nicht nur Hydra, den besten Schach-Supercomputer zu der damaligen Zeit, besiegen, sondern auch Teams von Großmeistern, die Computerprogramme benutzten. Die Teams aus Mensch und Maschine nannte man fortan Zentauren.

Mensch-Maschinen-Kooperation trumpft Künstliche Intelligenz

War der Sieg von Deep Blue über Kasparov ein Meilenstein, so war der Sieg des Mensch/Computer Teams über den Schachcomputer Hydra ein Quantensprung. Plötzlich konnten Schach-Amateure im Verbund mit menschlichen und computerisierten Kollegen die besten Schachprogramme der Welt schlagen. Dies eröffnete bisher unbekannte Spielweisen und -strategien. Durch das Auslagern der „Expertise“ entstanden neue Qualitäten und Vorteile. Liebhaber des “Centaur Chess” argumentieren, dass die Mensch-Maschinen-Paarung das Spiel auf ein noch nie erreichtes Niveau der Perfektion brachte. Fehlerfrei, taktisch perfekt und makellos strategisch ausgeführt.

Aber natürlich wird der Mensch weiterhin Fehler machen. Das liegt in seiner Natur. Doch er hat nun Houdini, Stockfish, Komodo oder Rybka an seiner Seite, die ihm helfen zu verstehen, welcher der beste nächste Zug sei.

Das spannende an “Centaur Chess” ist, dass nicht etwa Menschen wie Kasparov in dieser Variante glänzen. Sondern diejenigen, die die Kombination Mensch und Maschinen am besten steuern können. Selbst menschliche Amateure können starke Schachprogramme und sogar professionelle Zentauren schlagen. Es geht darum eine Schnittstelle zu bilden und die Maschinen auf die relevantesten Fragen hinzuweisen. Es geht darum, Meinungsverschiedenheiten zwischen den Programmen zu organisieren: Rybka hat das stärkste Eröffnungsbuch. Fritz ist besser in Endspielen. Houdini ist gut in der Verteidigung. Und so weiter.

Der schachspielende Zentaure ist nicht das einzige Beispiel für eine gelungene Mensch-Maschinen-Kooperation. Die Zentauren von Netflix verwenden Datenanalysen, um Nutzungs- und Bingewatching-Präferenzen zu ermitteln. Der Algorithmus erhebt Vorlieben zu Tropen, Akteuren und Handlungsstränge, die in der Folge von Drehbuchautoren verarbeitet werden. Sportarten, wie die Formel 1, oder Football, Baseball und mittlerweile sogar Fussball öffnen sich graduell Datenanalysen und nutzen bereits während des Spiels oder des Rennens Simulationen, um sich einen Vorteil gegenüber dem Gegner zu verschaffen. Abseits der Spielstätten ist es gängig auf Daten- und Technologieunterstützung zu setzen. Amazon Fulfillment Center sind ein gigantischer Zentaurenorganismus. Konstruktionssimulationen stützen sich beständig auf computergestütztes organisches Design, um Probleme zu lösen. Selbst wir werden zu Zentauren, weil wir tagtäglich unsere taktische Intelligenz in die Cloud auslagern.

Die Zukunft ist weniger Artificial Intelligence sondern mehr Intelligence Amplification

Die Technologie von Deep Blue legte den Grundstein für die Art und Weise, wie wir heute Daten verwenden und verarbeiten. Komplexe Computermodelle, die heute Finanzsysteme steuern, Konstruktionssimulationen berechnen oder neue Medikamente testen, verdanken ihre Leistung der Genialität des Multi-Chip-Systems von Deep Blue.

Jedoch haben die alten datenverarbeitenden Systeme nichts mit “Intelligenz” gemein. Häufig schreiben wir das Konzept Intelligenz linear fort. Mehr Leistung und mehr Speicher führt zu intelligenteren Prozessen. Intelligenz ist jedoch ein Zusammenspiel verschiedener kognitiver Systeme, die im Aggregat oder in der Mischung eine komplexe Sache hervorbringen, die wir Intelligenz nennen. Deduktives Denken, symbolisches Denken, Erinnerungen, Empathie und viele andere Arten von Intelligenz ergeben mehr als die Summe der Teile. Einzigartig macht uns die weitreichende Integration aller Intelligenzen.

IBM Deep Blue oder der Urenkel IBM Watson hingegen sind bessere Taschenrechner. Natürlich sind Taschenrechner uns in Arithmetikfragen überlegen. Wahrlich schlägt GPS die räumliche Navigation des Menschen und Suchmaschinen im Internet sind effizienter als wir, wenn es um das indexieren von Informationen geht. Aber all diese schmalen oder schwachen Intelligenzen arbeiten in einem “kind learning environment”, in denen bereits eine einfachste Mustererkennung zu übermenschlichen Resultaten führen kann. Um diese Ergebnisse zu erzielen muss man nicht wie ein Mensch denken. Es reicht schiere Computergewalt.

Das Gegenteil von „kind learning environments” sind “wicked domains”, in denen die Spielregeln häufig unbekannt oder unvollständig sind. Es existieren keine wiederkehrenden Muster und Feedback ist oft inakkurat und nicht augenblicklich. Erfahrungen, basierend auf Mustererkennung, führen hier häufig zur falschen Schlussfolgerung.

Abbildung 4: Ken Jennings, Watson und Brad Rutter an, TedBlog

Abbildung 4: Ken Jennings, Watson und Brad Rutter an, TedBlog

Deswegen funktioniert IBM Watson zum Beispiel gut, wenn er Jeopardy! spielt, aber er versagt kolossal in der Krebsforschung. Spielt man Jeopardy! sind die Regeln bekannt, es existieren Berge von Festplatten mit historischen Daten und das Feedback (richtig oder falsch) erzeugt einfache Muster. In der Krebsforschung hingegen müssen die Fragen erst gefunden werden, bevor man sich den Antworten widmen kann. Ähnlich erging es Google Flu Trends oder ergeht es derzeit Künstlichen Intelligenzen, die die ganze Komplexität des Verkehrs verstehen und verarbeiten müssen. Je offener die Welt, desto mehrdeutiger, chaotischer, unsicherer und volatiler ist sie. Gary Marcus, Professor of Psychology, Director NYU Center for Language and Music, beschreibt Künstliche Intelligenz deswegen mit den Worten:

AI systems are like savants. They need stable structures and narrow worlds.

Künstliche Intelligenz muss nicht so wie wir denken. Und genau das führt dazu, dass sie in engen Entwicklungsräumen, in denen sich die Spielregeln nicht ändern, sich hyperspezialisieren können.

AlphaGo, AlphaGoMaster, AlphaGoZero, AlphaZero und AlphaStar oder die Leiden von Sedol und Jie

In den letzten 20 Jahren haben sich KI-Systeme dramatisch weiterentwickelt. Man wähnte sich in einer neuen Ära, die sich nun nachhaltig und stetig etabliert. Doch dann schockte DeepMind die Welt.

Im Januar 2016 wurde bekannt, dass das Programm AlphaGo im Oktober 2015 den mehrfachen Go Europameister Fan Hui unter Turnierbedingungen besiegt hatte. Wegen der größeren Komplexität von Go gegenüber Schach, ist das Spiel mit traditionellen Brute-Force-Algorithmen, die bei Schachprogrammen zum Einsatz kommen, nicht bezwingbar. Existierende Programme hatten maximal die Stärke von ambitionierten Amateuren.

Abbildung 5: Fan Hui gegen AlphaGo, GeekandSundry

Abbildung 5: Fan Hui gegen AlphaGo, GeekandSundry

AlphaGo hingegen markiert einen erheblichen Entwicklungssprung. Es war das erste Go-Programm, das künstliche neuronale Netzwerke nutzte. Das Programm trainierte, durch die Analyse einer Datenbank mit 30 Millionen Zügen, den Zug eines Menschen „vorherzusagen“. Monte-Carlo-Algorithmen bewerten diese Prognosen statistisch und schlugen darauf einen eigenen Zug vor.

AlphaGo wurde auf einen Schlag bekannt. Im März 2016 schlug das Programm den Südkoreaner Lee Sedol, der als einer der weltbesten Profispieler gilt. Das Match wurde von 280 Millionen chinesischen Zuschauern verfolgt und wird von Kai-Fu Lee als China’s Sputnik Moment bezeichnet. Ein Jahr später zementierte AlphaGo seine Vormachtstellung, in dem das Programm Ke Jie, den Weltranglistenersten, drei mal hintereinander regelrecht demontierte.

Abbildung 6: Lee Sedol verliert Spiel 5

Abbildung 6: Lee Sedol verliert Spiel 5

Abbildung 7: Ke Jie gegen AlphaGo, Reuters/Stringer

Abbildung 7: Ke Jie gegen AlphaGo, Reuters/Stringer

Erneut wähnte man sich in einem neuen Zeitalter. Doch dann publizierten im Oktober 2017 die Entwickler von AlphaGo die Ergebnisse ihrer jüngsten Entwicklungsstufe: AlphaGoZero. Das Programm lernt von selbst. Im Gegensatz zu AlphaGo benötigt es keine Datenbank an Spielen, sondern nur die Regeln des Spiels. Das Programm simulierte Zillionen von Spielen gegen sich selbst und wird mit jedem Spiel besser. Es war schon nach 3 Tagen stärker als die AlphaGo-Version, die Lee Sedol besiegen konnte, und besiegte diese 100:0. Nach 40 Tagen Training schlug es sogar die jüngste und vormals stärkste Ausbaustufe des Programms, AlphaGoMaster.

Im Dezember 2017 stellte DeepMind den Nachfolger AlphaZero vor. Die verallgemeinerte Version von AlphaGoZero erlernte innerhalb weniger Stunden nacheinander die Spiele Schach, Go und Shōgi und konnte innerhalb von 24 Stunden übermenschliche Spiele spielen, die besten Programme der alten (Schach) Generation besiegen und ihre jeweiligen Programmvorgänger schlagen.

Mit anderen Worten: der Mensch hat ausgesorgt. Er trägt nicht mehr dazu bei, einer Maschine etwas beizubringen. Garry Kasparov kommentierte demütig:

„Die Auswirkungen sind offenbar wunderbar und weit jenseits von Schach und anderen Spielen. Die Fähigkeit einer Maschine menschliches Wissen aus Jahrhunderten in einem komplexen, geschlossenen System zu kopieren und zu überflügeln, ist ein Werkzeug, das die Welt verändern wird.“

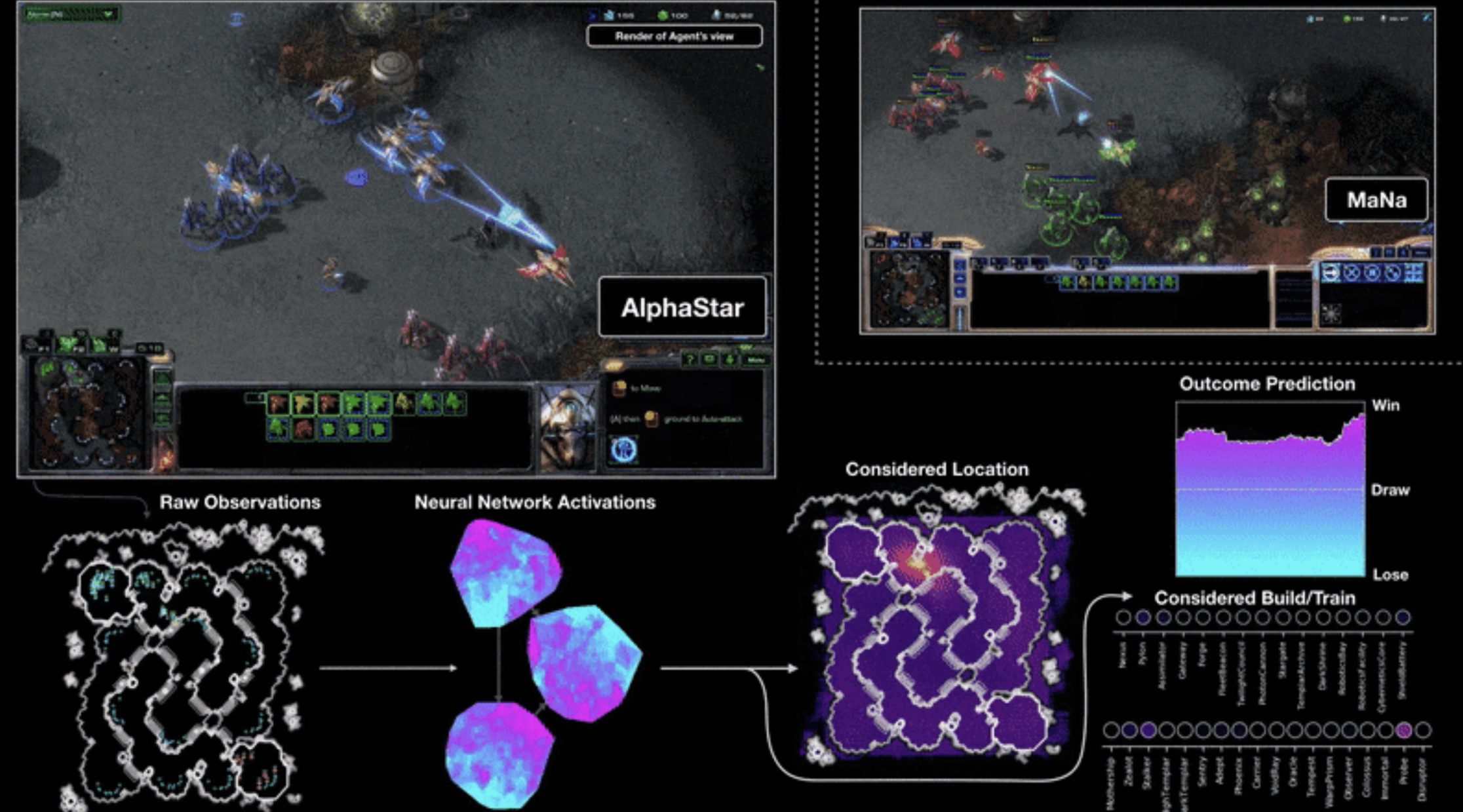

Die Frage, die sich stellt ist, ob sich das Zentauren-Modell, die Symphonie von Mensch und Maschine, damit abgeschafft hat und wir künftig beim Problemlösen nur auf Programme wie AlphaZero setzen sollten. Denn mittlerweile hat AlphaZero, beziehungsweise AlphaStar, schon bedeutend komplexere Spiele, wie z.b. das Computerspiel StarCraft II, gemeistert, welches weitaus komplexer als die Brettspiele Schach oder Go ist: Man muss Schlachten organisieren, Infrastrukturen planen, Geländer erkunden, Gegner ausspionieren und Ressourcen sammeln und verarbeiten. Bisher konnten Menschen mit ihrer Weitsicht und Anpassungsfähigkeit in diesen Spielen punkten. Denn in Videospielen können KI’s nicht die Bewegung der Figuren beobachten, um ihren nächsten Zug zu berechnen. Und sie müssen in Echtzeit reagieren.

Abbildung 8: AlphaStar gegen MaNa, Quelle: DeepMind

Abbildung 8: AlphaStar gegen MaNa, Quelle: DeepMind

Für das Schach- und Go-Spiel ist die Antwort jedenfalls zerschmetternd. AlphaZero spielt übermenschlich und schlägt alle bekannten Kombinationen aus Programmen und Zentauren. AlphaZero ist der neue König und die Sportarten findet sich in einem Warren Bennis Szenario wieder:

„The factory of the future will have only two employees, a man and a dog. The man will be there to feed the dog. The dog will be there to keep the man from touching the equipment.“

Die Sache hat jedoch glücklicherweise ein Aber: Am Anfang war AlphaZero und das Nichts. Nun blühen Open Source Forks von Alpha Zero auf, wie zum Beispiel Leela Zero, die wie ihr Ursprung Neuronale Netzwerke benutzen, um Go (Leela Zero Go) oder Schach (Leela Chess Zero) zu spielen. Vor kurzem besiegte die Facebook / Carnegie Mellon University KI Pluribus sogar mehrere Spieler beim Pokern.

Irgendwann wird es mehr Projekte dieser Art geben (weil Hardware und Software Anforderungen sinken) und sie werden sich nicht einig sein, welcher Zug in ihrer Umgebung der beste ist. Und an dieser Stelle kommt der Mensch zurück ins Spiel, der wie beim Centaur-Chess zwischen den angebotenen Optionen abwägen kann und die Entscheidung in eine langfristige Strategie integriert oder den Programmen Befehle gibt, sich auf bestimmte Probleme zu fokussieren. Magnus Carlsen, gegenwärtiger Schachweltmeister, zeigt zusätzlich einen zweiten Weg auf: Man kann die neue Kreativität der künstlichen Intelligenz zur Erweiterung der eigenen Kreativität nutzen, indem man Inspiration im Spiel der Maschine sucht.

Algorithmen sind und bleiben Werkzeuge, die, genau wie alle anderen Werkzeuge, überprüft, gewartet und kalibriert werden müssen

Seit geraumer Zeit wird über die horrenden Auswirkungen von Automatisierung und Künstlicher Intelligenz diskutiert. Man kann sich relativ einfach ausmalen, wie AlphaZero abseits von Brett- und Computerspielen eine Industrie nach der anderen verändert. Es winken Produktivitätszuwächse und effiziente Prozesse. Doch die Kehrseite sind radikale sozio-ökonomische Implikationen. Jeder Beruf oder Arbeitsplatz spürt die latente Gefahr, substituiert zu werden.

Auch wenn die Showdowns mit Kasparov, Jennings, Sedol und Jie retrospektiv disruptiv wirken, ist die technologische Entwicklung inkrementell. Wir haben Computer die Schach, Go, Poker oder StarCraft II spielen, Röntgenbilder lesen, das Wetter vorhersagen, mit 100 km/h die Autobahn hinunterfahren, unsere Stimme verstehen, in Dokumenten nach Fehlern suchen, traditionelle Bankarbeit erledigen, buchhalterisch tätig sind, unser Haus wärmen, Spielsucht identifizieren, Anwälten helfen, Fonds verwalten, die günstigsten Flugpreise finden, Aufsichtsratspositionen übernehmen, Aktien handeln, Pakete sortieren oder ein Gesicht in der Menge identifizieren können.

Computer erledigen einige dieser Aufgaben bisweilen selbstverständlich und besser als wir Menschen. Heute beschwert sich niemand mehr, dass der Computer uns Alternativrouten vorschlägt oder günstigere Flüge am Folgetag anbietet. Graduell haben Maschinen das Ruder übernommen und erledigen eine klar definierte Aufgabe über menschlichem Niveau. Somit verschwinden Betätigungsfelder mit jedem Jahr, in denen Menschen eine Rolle gespielt haben. Möchte man es positiv beschreiben, müsste man sagen, dass die Wirkung auf individueller Ebene schicksalsvoll ist und dennoch im universellem Schema der Dinge unausweichlich.

Wenn Künstliche Intelligenz etwas ist, dann eine Aktivierungsschicht, die nicht nur bessere Antworten zu bekannten Fragen liefert. Sie hilft, neue Fragen in bestehenden Datensätzen zu identifizieren und wird dafür künftig auf Stimmen, Bilder und Videos zurückgreifen können. Jede Industrie und jedes Vertikal hat ihre eigenen, einzigartigen Probleme, die durch Machine Learning automatisiert werden können.

Was wir als Mensch in die Waagschale werfen können, ist das komplette Gegenteil der objektiven, rationalen Hyperspezialisierung der künstlichen Intelligenz. AlphaStar zeigte uns, dass je größer das zu bearbeitende Bild ist, je komplexer die Umwelt und das Problem (siehe zum Beispiel die Themenkomplexe Autonome Mobilität oder Krebsforschung), desto wichtiger bleibt der menschliche Einfluss. Wir können allgemein, kreativ und weitreichend mehrere Optionen in die gegenwärtige Problemlösung integrieren und basierend darauf eine Entscheidung fällen, die sich strategisch, langfristig ausspielen wird. Im Gegensatz zu den Maschinen können wir zudem empathisch und achtsam sein, kreativ Probleme lösen und Gemeinschaft pflegen und leben.

Richten wir den Fokus auf die Kollaboration, auf den Zentauren, liegt in der Mensch-Maschinen-Symbiose weiterhin eine große Chance der Zukunft. Künstliche Intelligenzen (mehrere konkurrierende Programme) können Ärzten bei der Diagnose unter die Arme greifen, sodass diese sich auf den Menschen konzentrieren können. Niemand will von einer Maschine behandelt werden, doch haben wir erkannt, dass Maschinen besser darin sind Hautauffälligkeiten zu erkennen. Zudem skalieren sie besser, was man von Experten nicht sagen kann. Ähnliche Entwicklungen sind im Bereich der Bildung (Umgekehrter Unterricht), im Rechtswesen (mehr Kommunikation mit Klienten), im Verkehr (Schaffung eines dritten Lebensraumes), bei der Organisation von Events (einfache automatisierte Terminkoordination), in der Kunst (Erschaffung neuer Welten) oder im Handel (weniger Kassierer, dafür mehr “Concierges” die sich individuell um die Bedürfnisse ihrer Kunden kümmern) denkbar.

Auch wenn der Ausblick rosig klingen mag, gefährlich ist und bleibt indessen die Entwicklung, dass wir uns von Maschinen abhängig machen, die entwickelt wurden, um die rasant steigende Komplexität der Welt zu managen. Wir dürfen nicht den Fehler begehen und uns in diese Unmündigkeit begeben.

Algorithmen stellen uns heute partiell bereits nur noch die Informationen zur Verfügung, die wir sehen sollen oder verstehen können. Sie übersetzen oder interveniert für uns, so dass wir Menschen uns nicht mehr gegenseitig verstehen müssen. Natürlich stehen auf der möglichen Habenseite viele potenzielle Vorzüge. Dennoch werden wir geschwächt. Denn teilweise verstehen wir gar nicht mehr, wie künstliche neuronale Netzwerke funktionieren. Wir fragen auch nicht nach, wenn das Ergebnis stimmt. Wenn aber zukünftig Intelligenzen vermitteln sollen, wird uns mittelfristig die Fähigkeit abhanden kommen, sich komplexen Problemen selbstständig zu widmen. Künstliche Intelligenzen werden uns das Verständnis nehmen. Sie werden uns den Zugang zur Entscheidungsfindung entziehen und verbieten. Vielleicht bekommen wir noch die Rohdaten. Aber da Algorithmen nicht wie Menschen “denken”, besteht permanent die Gefahr, dass Datenverzerrungen erzeugt oder im Prozess weitergegeben werden. Fehler sind nie auszuschließen.

Will der Mensch die Kontrolle behalten, muss er die Deutungshoheit bewahren. Denn wenn die Maschine nicht mehr verstanden wird, man ihr jedoch kompromisslos vertraut, überschreiten wir eine verhängnisvolle Schwelle.

Das menschliche Vertrauen in hyperspezialisierte Intelligenzen ist daher extrem bedrohlich. Irgendwann vertrauen wir ihnen Entscheidungen ausserhalb ihrer stabilen und engen Strukturen an. Bevor wir überhaupt nur im Ansatz über eine todbringende “Artificial General Intelligence” mit Bewusstsein sprechen können, wurde das Ende der Menschheit bereits von einer KI mit dem Bewusstsein eines dreijährigen Kindes besiegelt, welche aus Versehen auf den falschen Knopf gedrückt hat.

Es war schon immer wichtig, über den Einsatz und die Wirkung von Künstlicher Intelligenz zu sprechen. Doch gegenwärtig scheint es dringender denn je. Die fast paradigmatischen Ereignisse Kasparov, Jennings, Hui, Sedol und Jie sollten uns eine Warnung sein. Denn die Zukunft verbirgt sich geschickt in der Gegenwart. Noch haben wir die Chance offen über Abhängigkeiten und Vertrauen zu sprechen. Noch können uns Maschinen helfen, Dinge besser zu verstehen. Wir sollten nur nie Künstliche Intelligenzen zwischen uns und unser Verständnis lassen.

Further Reading:

- Google Math AI

- Microsoft says its AI mahjong bot has surpassed top human players

- Restoring ancient text using deep learning: a case study on Greek epigraphy

- Normcore Tech: Neural nets are just people all the way down - Is machine learning really powered by machines? (No)

- A neural net solves the three-body problem 100 million times faster

- Von Schach bis “Starcraft 2”: Wenn der Computer zum besseren Spieler wird

- DeepMind’s StarCraft 2 AI is now better than 99.8 percent of all human players and blog post Deepmind

- Former Go champion beaten by DeepMind retires after declaring AI invincible

Interessante Perspektive, siehe Beitrag Quantenüberlegenheit:

As Boaz Barak put it to me, the current contest between IBM and Google is analogous to Kasparov versus Deep Blue—except with the world-historic irony that IBM is playing the role of Kasparov! In other words, Kasparov can put up a heroic struggle, during a “transitional period” that lasts a year or two, but the fundamentals of the situation are that he’s toast. If Kasparov had narrowly beaten Deep Blue in 1997, rather than narrowly losing, the whole public narrative would likely have been different (“humanity triumphs over computers after all!”). Yet as Kasparov himself well knew, the very fact that the contest was close meant that, either way, human dominance would soon end for good.

Von Scott Aaronson’s Blog Shtetl-Optimized.

Pocket Guide to Digital Transformation longthoughts