August 14, 2019

Stephen Elop (Ex Nokia CEO)

On the Nokia case:

»We didn’t do anything wrong, but somehow, we lost.«

Why ecosystems matter:

»The battle of devices has now become a war of ecosystems, where ecosystems include not only the hardware and software of the device, but developers, applications, ecommerce, advertising, search, social applications, location‐based services, unified communications and many other things. Our competitors aren’t taking our market share with devices; they are taking our market share with an entire ecosystem. This means we’re going to have to decide how we either build, catalyse or join an ecosystem.«

Nokia

Innovation

Ecosystems

quotes

August 12, 2019

Mortimer Adler (American philosopher)

»The person who says he knows what he thinks but cannot express it usually does not know what he thinks.«

quotes

August 12, 2019

The Feynman Technique

The more you teach, the better you learn.

- Choose a concept you want to learn about.

- Pretend you are teaching it to a student in grade 6.

- Identify gaps in your explanation; Go back to the source material, to better understand it.

- Review and simplify it to understand it better (optional)

- Go back to step 2.

concepts

August 12, 2019

Kraft- und Parameterkontrolle

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Wenn Störungen schleichend auftreten, können abrupte Veränderungen folgen. Geringfügige Beeinträchtigungen können sich in der Summe exponentiell entwickeln und ein vormals stabiles System innerhalb weniger Momente zum Erliegen bringen: Wasser gefriert plötzlich, ein Verkehrsstau entsteht völlig unerwartet, ein Waldbrand bricht unvermittelt aus, ein digitales Netzwerk erreicht innerhalb von wenigen Monaten Millionen Nutzer oder ein Markt wird unvorhergesehen von Startups „disruptiert“.

Wirken die Kräfte auf ein einzelnes Atom, ein Individuum oder ein Unternehmen, bedingen die Kräfte oft nur eine allmähliche Veränderung. Multipliziert man die Störungen jedoch hundert-, tausend- oder sogar millionenfach, kann sich das höhergelagerte System von einem Moment auf den anderen komplett verändern.

Die Folge einer Phasenverschiebung sind neue Spielregeln, die den wahrenden Kräften oftmals nicht gefallen. Erkennt man die Kräfte rechtzeitig, kann man ihnen entgegenwirken oder sie zum eigenen Vorteil nutzen. Oft muss man sich aber eingestehen, dass man die Veränderung erst mit der kompletten Phasenverschiebung erkannt hat.

Möchte man einen Phasenübergang organisieren und kontrollieren, muss man die handelnden Kräfte studieren und die wichtigsten Kontrollparameter definieren. Erst wenn ich weiß, dass der Parameter „durchschnittlicher Abstand zwischen Fahrzeugen auf der Autobahn“ und der Parameter „Geschwindigkeit der Fahrzeuge“ im Zusammenspiel fließenden oder nicht-fließenden Verkehr ergeben, kann ich versuchen das System zu verstehen und zu kontrollieren.

Corporate Innovation

Disruption

Phasenübergang

Pocket Guide to Digital Transformation

mediumthoughts

August 12, 2019

Innovationen

Innovationen, die nicht im Markt schwingen, sind keine Innovationen.

innovation

Faustregel

August 12, 2019

Daten

Daten, die gesammelt werden, gehen nie verloren. Mindestens werden sie von der erhebenden Partei für eigene Zwecke analysiert und verarbeitet. Im Bestfall werden sie an Dritte verkauft.

data

Faustregel

August 1, 2019

Niemals darf KI sich zwischen uns und unser Verständnis stellen

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Kasparov, Jennings, Hui, Sedol und Jie. Fünf Namen und Biographien, die eng mit der Geschichte der Künstlichen Intelligenz verwoben sind. Alle zogen siegessicher in die Schlacht, hatten aber schon zur Halbzeit keine Chance mehr. Sie wurden brutal durch Rechengewalt in die Knie gezwungen oder von einer außerirdischen nicht-empfindungsfähigen Intelligenz überlistet. Die Moral der Geschichte: Künstliche Intelligenz dürfen sich nie zwischen uns und unser Verständnis stellen. Wir dürfen uns nicht von Black Boxes abhängig machen. KI ist maximal eine Aktivierungsschicht, die uns hilft spezifische Probleme besser zu verstehen.

Im siebten Zug des entscheidenden Spiels machte Schwarz einen kritischen Fehler. Weiß nutzte den Vorteil, opferte einen Springer und schuf einen neuen Angriff. Elf Züge später hatte Weiß eine dermaßen starke Position aufgebaut, dass Schwarz sich die Niederlage eingestehen musste. Der Verlierer reagierte entrüstet und warf Weiß Betrug vor. Ein Vorwurf, der 22 Jahre später noch im Raum steht. Es ist nicht ungewöhnlich, dass der Verlierer den Gewinner des Betrugs beschuldigt. Aber in diesem Fall hieß der Verlierer Garry Kasparov und der Sieger war ein Computer namens IBM Deep Blue.

Abbildung 1: Garry Kasparov, 1985, Wikimedia

Abbildung 1: Garry Kasparov, 1985, Wikimedia

Garry Kasparov wurde mit einem gesunden Selbstvertrauen geboren. Er hatte im Leben eines Schachspielers alles erreicht und seinen Sport über Jahre dominiert. Mit 17 bekam er den Titel eines Großmeisters verliehen und im selben Jahr gewann er in Dortmund die Junioren-Weltmeisterschaft. Sechs Jahre später wurde er offizieller Weltmeister des Weltschachbundes FIDE und behielt den Titel bis ins Jahr 2000.

In seiner Karriere trat er mehrmals unter Wettkampfbedingungen gegen Schachprogramme an. In den 1980er Jahren hatte er behauptet, er werde niemals von einem Schachprogramm besiegt werden. Und so spielte er voller Selbstsicherheit 1989 gegen den von IBM gebauten Supercomputer Deep Thought zwei Partien, die er beide gewann. Sieben Jahre später besiegte Kasparow in Philadelphia dessen Nachfolger Deep Blue in einem Match über sechs Partien mit 4:2, verlor mit der 1. Wettkampfpartie aber als erster Schachweltmeister überhaupt gegen einen Computer. Immerhin stand Deep Blue auf der Rangliste der mächtigsten Computer der Welt auf Platz 259 und war ausschließlich mit Schachspielen beschäftigt.

Kasparov war sich sicher, dass er 15 Monate später im Rückspiel in New York gegen Deep Blue bestehen und siegreich aus der Partie heraus gehen würde. Doch es kam alles anders. Am 11. Mai 1997 unterlag er in der entscheidenden sechsten Partie und verlor den Wettkampf mit 2,5:3,5.

Auf den Videoaufnahmen ist Kasparow die Verzweiflung und Hilflosigkeit anzusehen. Nach knapp vier Minuten gibt er auf. Deep Blue, der 200 Millionen Stellungen pro Sekunde berechnen oder bis zu 40 oder mehr Züge in die Zukunft “sehen” konnte, war ein zu starker, zu emotionsloser, zu logischer Gegner. Deep Blue, die geistreiche Erfindung von Feng-Hsiung Hsu, hat Kasparov mit einfachen Regeln, effizienten Taktiken und mathematischer roher Gewalt in die Knie gezwungen.

Abbildung 2: Sechstes und letztes Spiel im Rematch zwischen Schachweltmeister Garry Kasparov und IBM-Supercomputer Deep Blue, New York, 1997

Abbildung 2: Sechstes und letztes Spiel im Rematch zwischen Schachweltmeister Garry Kasparov und IBM-Supercomputer Deep Blue, New York, 1997

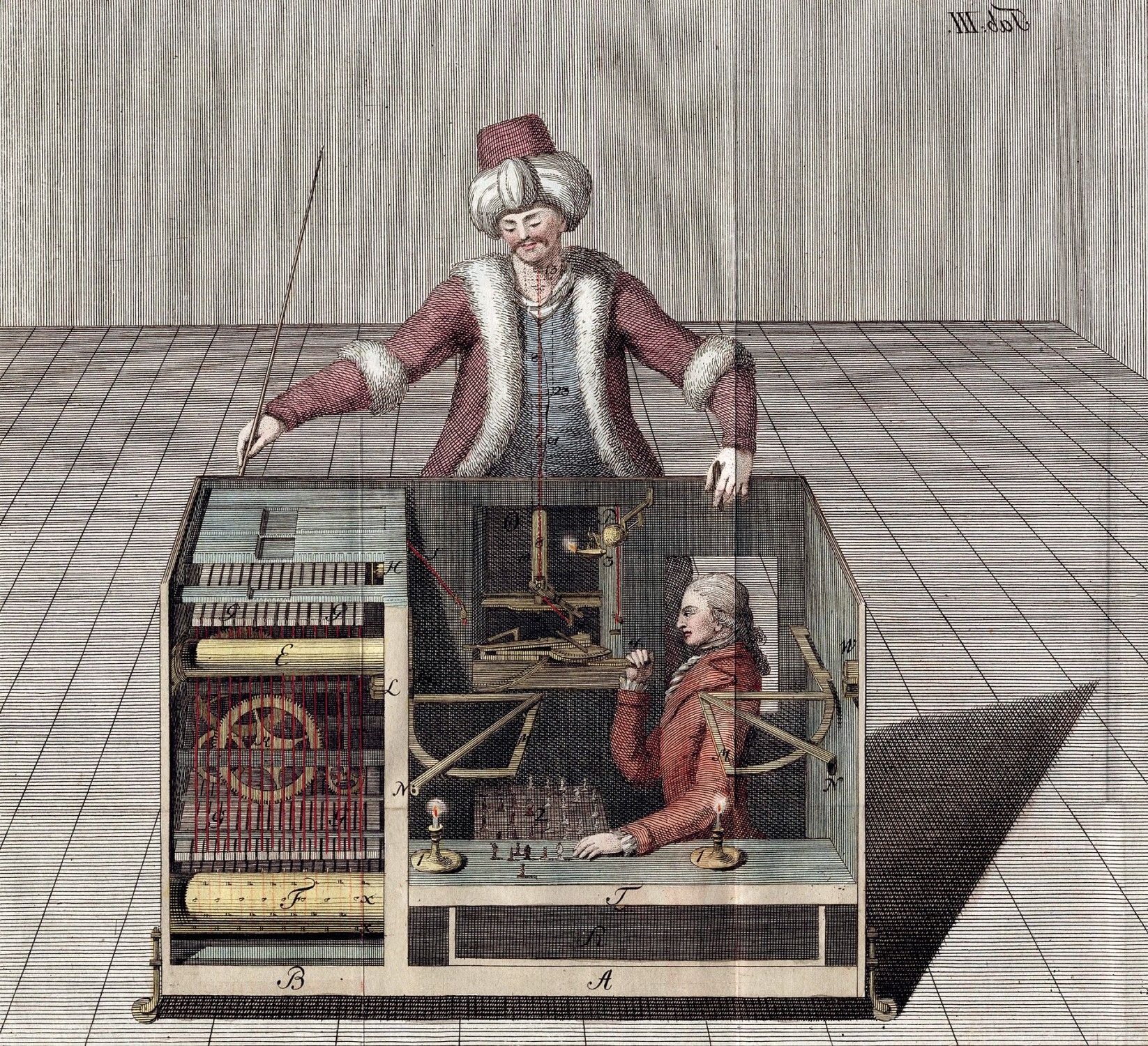

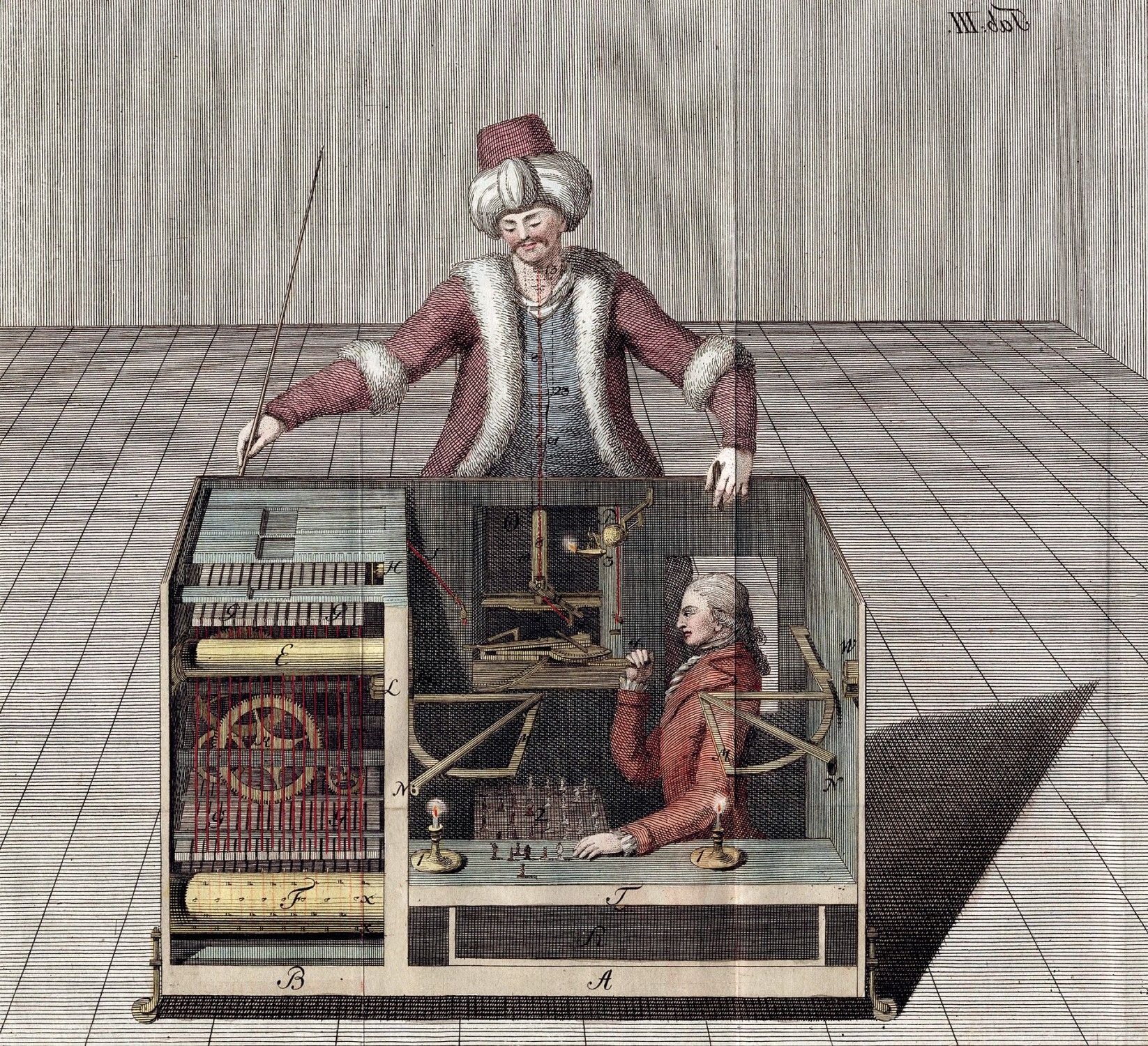

Nach dem Spiel war Kasparov frustriert und uneinsichtig. Er beschuldigte das Deep Blue-Team, dem Computer geholfen zu haben. Er behauptete, dass einige der Züge so intelligent und kreativ gewesen seien, dass nur Menschen dahinter stecken können. Er war der Überzeugung, dass eine moderne Version des Schachtürken ihn geschlagen hätte. Doch wie die Geschichte zeigte, stellte sich der Vorwurf und die vielen Verschwörungstheorien als haltlos heraus. Kasparov verlor, weil er menschliche Züge zeigte und zu viel in die Züge der Maschine hineininterpretierte.

Viele Jahre später zeigte Kasparov sich geläutert: “While writing my book I did a lot of research — analyzing the games with modern computers, also soul-searching — and I changed my conclusions. I am not writing any love letters to IBM, but my respect for the Deep Blue team went up, and my opinion of my own play, and Deep Blue’s play, went down. Today you can buy a chess engine for your laptop that will beat Deep Blue quite easily.“

In der Folge kanalisierte er seine Frustration in der Suche nach einem Weg, um das Schachspiel vor der Dominanz der Maschinen zu retten. Er erkannte etwas, das KI-Forscher das Moravec’sche Paradox nennen. Maschinen und Menschen haben gegensätzliche Stärken und Schwächen. Moravec schreibt:

„Es ist vergleichsweise einfach, Computer dazu zu bringen, Leistungen auf Erwachsenenniveau bei Intelligenztests oder beim Dame spielen zu erbringen, und schwierig oder unmöglich, ihnen die Fähigkeiten eines Einjährigen in Bezug auf Wahrnehmung und Mobilität zu vermitteln.“

Ein Sprichwort besagt, dass Schach zu 99 Prozent Taktik ist. Taktiken sind Zugkombinationen, mit denen man einen Vorteil auf dem Brett erzielen kann. Wenn man diese Taktiken studiert (so wie es Deep Thought mit der Karriere von Kasparov getan hat), beherrscht man die Taktiken und gewinnt die ersten Schlachten. Sich dann zu fragen, warum der Zug schlecht war, kann dabei helfen, die Taktik zu verbessern. Sich aber zu fragen, warum man den Zug unter den herrschenden Umständen gewählt hat, hilft, die Strategie künftig anzupassen. Und wie wir alle wissen, gewinnt man Kriege nur mit einer guten Strategie.

Computer sind im Vergleich zu Menschen Taktikkönige. Aufgrund ihrer Rechenleistung und Effizienz sind sie in der Lage, Muster in Millisekunden zu erkennen und dementsprechend zu reagieren. In gewisser Weise funktionieren die Gehirne von Schachgroßmeistern ähnlich. Die meisten Großmeister haben kein „photographisches Gedächtnis“. Sie erinnern sich eher an Situationen, an Spielgruppen beziehungsweise an Muster aus ihrer Vergangenheit. Basierend auf ihrer Erfahrung, können sie in wenigen Sekunden die Situation einschätzen und den nächsten Zug planen.

Abbildung 3: Der Schachtürke, Wikimedia

Abbildung 3: Der Schachtürke, Wikimedia

Mit dem Siegeszug der Computer wurden die Taktik-Kenntnisse der Schachgroßmeister egalisiert. Sie wurden ausgelagert. Damit verlagerte sich der Fokus von der Taktik zur Strategie. Kasparov stellte in der Zeit fest, dass der Mensch nur eine Chance gegen Maschinen haben wird, wenn er seine Kreativität in den Vordergrund stellen wird. Er fragte sich fortan, was passieren würde, wenn man die taktischen Fähigkeiten der Computer mit dem großformatigen Denken der Menschen kombinieren würde.

1998 fand das von Kasparov ins Leben gerufene erste “Advanced Chess”-Turnier statt, bei dem jeder menschliche Spieler, darunter Kasparov selbst, mit einem Computerprogramm zusammenarbeitete. In der Folge entwickelte sich eine weitere Spielart namens „Freestyle Chess“, die weniger restriktiv war und das Spielen in Teams erlaubte. So konnte ein Duo von Amateurspielern mit drei Computern 2014 nicht nur Hydra, den besten Schach-Supercomputer zu der damaligen Zeit, besiegen, sondern auch Teams von Großmeistern, die Computerprogramme benutzten. Die Teams aus Mensch und Maschine nannte man fortan Zentauren.

Mensch-Maschinen-Kooperation trumpft Künstliche Intelligenz

War der Sieg von Deep Blue über Kasparov ein Meilenstein, so war der Sieg des Mensch/Computer Teams über den Schachcomputer Hydra ein Quantensprung. Plötzlich konnten Schach-Amateure im Verbund mit menschlichen und computerisierten Kollegen die besten Schachprogramme der Welt schlagen. Dies eröffnete bisher unbekannte Spielweisen und -strategien. Durch das Auslagern der „Expertise“ entstanden neue Qualitäten und Vorteile. Liebhaber des “Centaur Chess” argumentieren, dass die Mensch-Maschinen-Paarung das Spiel auf ein noch nie erreichtes Niveau der Perfektion brachte. Fehlerfrei, taktisch perfekt und makellos strategisch ausgeführt.

Aber natürlich wird der Mensch weiterhin Fehler machen. Das liegt in seiner Natur. Doch er hat nun Houdini, Stockfish, Komodo oder Rybka an seiner Seite, die ihm helfen zu verstehen, welcher der beste nächste Zug sei.

Das spannende an “Centaur Chess” ist, dass nicht etwa Menschen wie Kasparov in dieser Variante glänzen. Sondern diejenigen, die die Kombination Mensch und Maschinen am besten steuern können. Selbst menschliche Amateure können starke Schachprogramme und sogar professionelle Zentauren schlagen. Es geht darum eine Schnittstelle zu bilden und die Maschinen auf die relevantesten Fragen hinzuweisen. Es geht darum, Meinungsverschiedenheiten zwischen den Programmen zu organisieren: Rybka hat das stärkste Eröffnungsbuch. Fritz ist besser in Endspielen. Houdini ist gut in der Verteidigung. Und so weiter.

Der schachspielende Zentaure ist nicht das einzige Beispiel für eine gelungene Mensch-Maschinen-Kooperation. Die Zentauren von Netflix verwenden Datenanalysen, um Nutzungs- und Bingewatching-Präferenzen zu ermitteln. Der Algorithmus erhebt Vorlieben zu Tropen, Akteuren und Handlungsstränge, die in der Folge von Drehbuchautoren verarbeitet werden. Sportarten, wie die Formel 1, oder Football, Baseball und mittlerweile sogar Fussball öffnen sich graduell Datenanalysen und nutzen bereits während des Spiels oder des Rennens Simulationen, um sich einen Vorteil gegenüber dem Gegner zu verschaffen. Abseits der Spielstätten ist es gängig auf Daten- und Technologieunterstützung zu setzen. Amazon Fulfillment Center sind ein gigantischer Zentaurenorganismus. Konstruktionssimulationen stützen sich beständig auf computergestütztes organisches Design, um Probleme zu lösen. Selbst wir werden zu Zentauren, weil wir tagtäglich unsere taktische Intelligenz in die Cloud auslagern.

Die Zukunft ist weniger Artificial Intelligence sondern mehr Intelligence Amplification

Die Technologie von Deep Blue legte den Grundstein für die Art und Weise, wie wir heute Daten verwenden und verarbeiten. Komplexe Computermodelle, die heute Finanzsysteme steuern, Konstruktionssimulationen berechnen oder neue Medikamente testen, verdanken ihre Leistung der Genialität des Multi-Chip-Systems von Deep Blue.

Jedoch haben die alten datenverarbeitenden Systeme nichts mit “Intelligenz” gemein. Häufig schreiben wir das Konzept Intelligenz linear fort. Mehr Leistung und mehr Speicher führt zu intelligenteren Prozessen. Intelligenz ist jedoch ein Zusammenspiel verschiedener kognitiver Systeme, die im Aggregat oder in der Mischung eine komplexe Sache hervorbringen, die wir Intelligenz nennen. Deduktives Denken, symbolisches Denken, Erinnerungen, Empathie und viele andere Arten von Intelligenz ergeben mehr als die Summe der Teile. Einzigartig macht uns die weitreichende Integration aller Intelligenzen.

IBM Deep Blue oder der Urenkel IBM Watson hingegen sind bessere Taschenrechner. Natürlich sind Taschenrechner uns in Arithmetikfragen überlegen. Wahrlich schlägt GPS die räumliche Navigation des Menschen und Suchmaschinen im Internet sind effizienter als wir, wenn es um das indexieren von Informationen geht. Aber all diese schmalen oder schwachen Intelligenzen arbeiten in einem “kind learning environment”, in denen bereits eine einfachste Mustererkennung zu übermenschlichen Resultaten führen kann. Um diese Ergebnisse zu erzielen muss man nicht wie ein Mensch denken. Es reicht schiere Computergewalt.

Das Gegenteil von „kind learning environments” sind “wicked domains”, in denen die Spielregeln häufig unbekannt oder unvollständig sind. Es existieren keine wiederkehrenden Muster und Feedback ist oft inakkurat und nicht augenblicklich. Erfahrungen, basierend auf Mustererkennung, führen hier häufig zur falschen Schlussfolgerung.

Abbildung 4: Ken Jennings, Watson und Brad Rutter an, TedBlog

Abbildung 4: Ken Jennings, Watson und Brad Rutter an, TedBlog

Deswegen funktioniert IBM Watson zum Beispiel gut, wenn er Jeopardy! spielt, aber er versagt kolossal in der Krebsforschung. Spielt man Jeopardy! sind die Regeln bekannt, es existieren Berge von Festplatten mit historischen Daten und das Feedback (richtig oder falsch) erzeugt einfache Muster. In der Krebsforschung hingegen müssen die Fragen erst gefunden werden, bevor man sich den Antworten widmen kann. Ähnlich erging es Google Flu Trends oder ergeht es derzeit Künstlichen Intelligenzen, die die ganze Komplexität des Verkehrs verstehen und verarbeiten müssen. Je offener die Welt, desto mehrdeutiger, chaotischer, unsicherer und volatiler ist sie. Gary Marcus, Professor of Psychology, Director NYU Center for Language and Music, beschreibt Künstliche Intelligenz deswegen mit

den Worten:

AI systems are like savants. They need stable structures and narrow worlds.

Künstliche Intelligenz muss nicht so wie wir denken. Und genau das führt dazu, dass sie in engen Entwicklungsräumen, in denen sich die Spielregeln nicht ändern, sich hyperspezialisieren können.

AlphaGo, AlphaGoMaster, AlphaGoZero, AlphaZero und AlphaStar oder die Leiden von Sedol und Jie

In den letzten 20 Jahren haben sich KI-Systeme dramatisch weiterentwickelt. Man wähnte sich in einer neuen Ära, die sich nun nachhaltig und stetig etabliert. Doch dann schockte DeepMind die Welt.

Im Januar 2016 wurde bekannt, dass das Programm AlphaGo im Oktober 2015 den mehrfachen Go Europameister Fan Hui unter Turnierbedingungen besiegt hatte. Wegen der größeren Komplexität von Go gegenüber Schach, ist das Spiel mit traditionellen Brute-Force-Algorithmen, die bei Schachprogrammen zum Einsatz kommen, nicht bezwingbar. Existierende Programme hatten maximal die Stärke von ambitionierten Amateuren.

Abbildung 5: Fan Hui gegen AlphaGo, GeekandSundry

Abbildung 5: Fan Hui gegen AlphaGo, GeekandSundry

AlphaGo hingegen markiert einen erheblichen Entwicklungssprung. Es war das erste Go-Programm, das künstliche neuronale Netzwerke nutzte. Das Programm trainierte, durch die Analyse einer Datenbank mit 30 Millionen Zügen, den Zug eines Menschen „vorherzusagen“. Monte-Carlo-Algorithmen bewerten diese Prognosen statistisch und schlugen darauf einen eigenen Zug vor.

AlphaGo wurde auf einen Schlag bekannt. Im März 2016 schlug das Programm den Südkoreaner Lee Sedol, der als einer der weltbesten Profispieler gilt. Das Match wurde von 280 Millionen chinesischen Zuschauern verfolgt und wird von Kai-Fu Lee als China’s Sputnik Moment bezeichnet. Ein Jahr später zementierte AlphaGo seine Vormachtstellung, in dem das Programm Ke Jie, den Weltranglistenersten, drei mal hintereinander regelrecht demontierte.

Abbildung 6: Lee Sedol verliert Spiel 5

Abbildung 6: Lee Sedol verliert Spiel 5

Abbildung 7: Ke Jie gegen AlphaGo, Reuters/Stringer

Abbildung 7: Ke Jie gegen AlphaGo, Reuters/Stringer

Erneut wähnte man sich in einem neuen Zeitalter. Doch dann publizierten im Oktober 2017 die Entwickler von AlphaGo die Ergebnisse ihrer jüngsten Entwicklungsstufe: AlphaGoZero. Das Programm lernt von selbst. Im Gegensatz zu AlphaGo benötigt es keine Datenbank an Spielen, sondern nur die Regeln des Spiels. Das Programm simulierte Zillionen von Spielen gegen sich selbst und wird mit jedem Spiel besser. Es war schon nach 3 Tagen stärker als die AlphaGo-Version, die Lee Sedol besiegen konnte, und besiegte diese 100:0. Nach 40 Tagen Training schlug es sogar die jüngste und vormals stärkste Ausbaustufe des Programms, AlphaGoMaster.

Im Dezember 2017 stellte DeepMind den Nachfolger AlphaZero vor. Die verallgemeinerte Version von AlphaGoZero erlernte innerhalb weniger Stunden nacheinander die Spiele Schach, Go und Shōgi und konnte innerhalb von 24 Stunden übermenschliche Spiele spielen, die besten Programme der alten (Schach) Generation besiegen und ihre jeweiligen Programmvorgänger schlagen.

Mit anderen Worten: der Mensch hat ausgesorgt. Er trägt nicht mehr dazu bei, einer Maschine etwas beizubringen. Garry Kasparov kommentierte demütig:

„Die Auswirkungen sind offenbar wunderbar und weit jenseits von Schach und anderen Spielen. Die Fähigkeit einer Maschine menschliches Wissen aus Jahrhunderten in einem komplexen, geschlossenen System zu kopieren und zu überflügeln, ist ein Werkzeug, das die Welt verändern wird.“

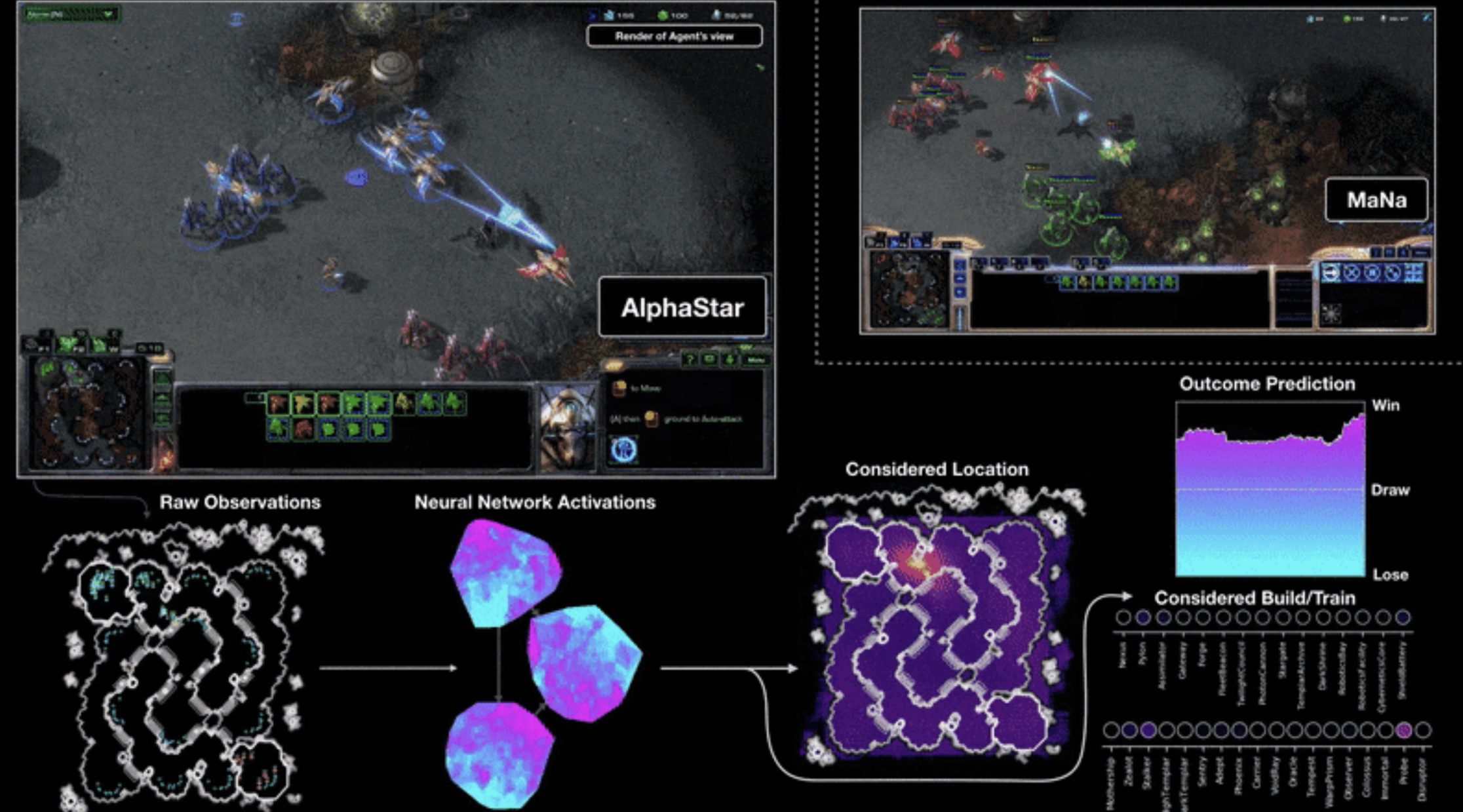

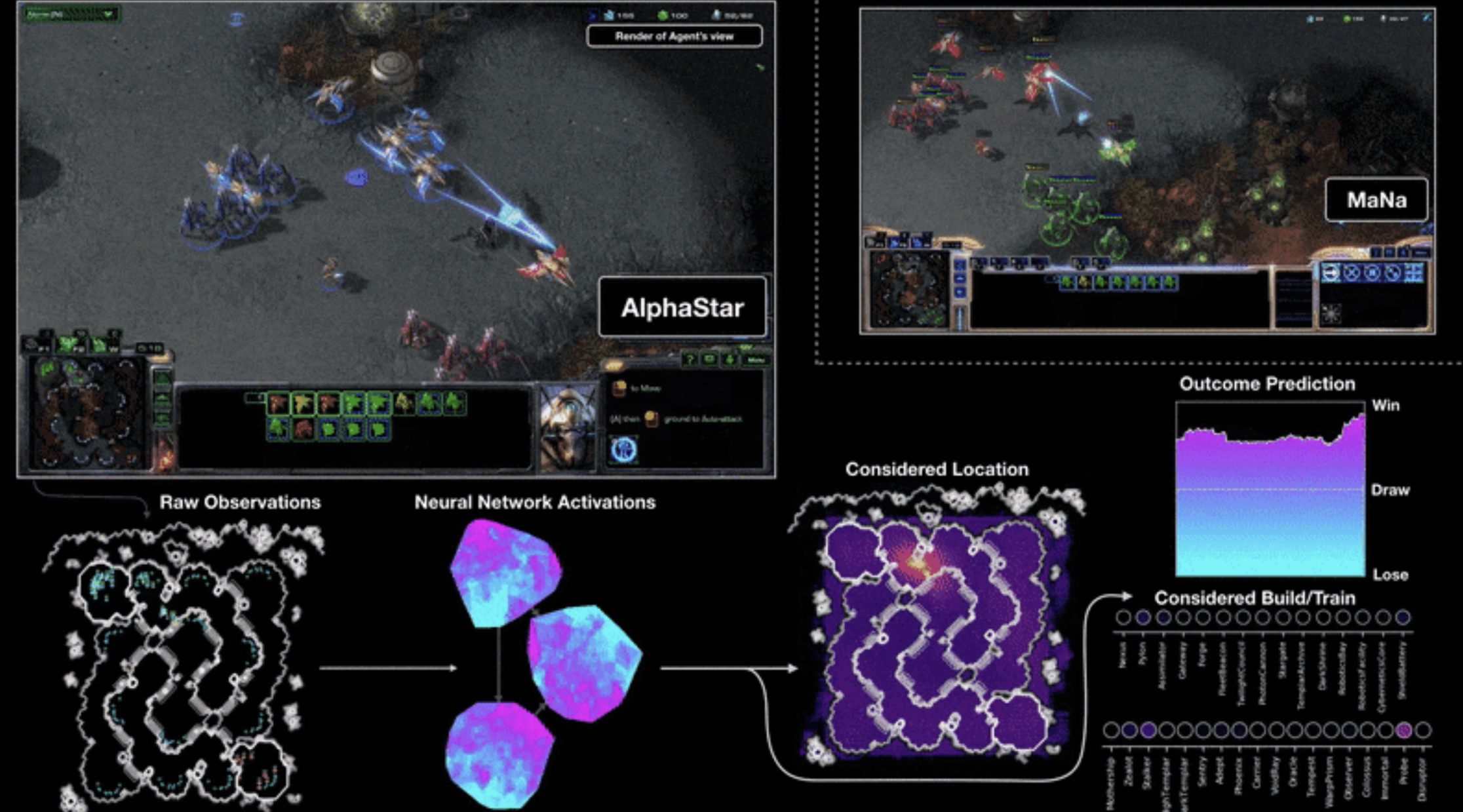

Die Frage, die sich stellt ist, ob sich das Zentauren-Modell, die Symphonie von Mensch und Maschine, damit abgeschafft hat und wir künftig beim Problemlösen nur auf Programme wie AlphaZero setzen sollten. Denn mittlerweile hat AlphaZero, beziehungsweise AlphaStar, schon bedeutend komplexere Spiele, wie z.b. das Computerspiel StarCraft II, gemeistert, welches weitaus komplexer als die Brettspiele Schach oder Go ist: Man muss Schlachten organisieren, Infrastrukturen planen, Geländer erkunden, Gegner ausspionieren und Ressourcen sammeln und verarbeiten. Bisher konnten Menschen mit ihrer Weitsicht und Anpassungsfähigkeit in diesen Spielen punkten. Denn in Videospielen können KI’s nicht die Bewegung der Figuren beobachten, um ihren nächsten Zug zu berechnen. Und sie müssen in Echtzeit reagieren.

Abbildung 8: AlphaStar gegen MaNa, Quelle: DeepMind

Abbildung 8: AlphaStar gegen MaNa, Quelle: DeepMind

Für das Schach- und Go-Spiel ist die Antwort jedenfalls zerschmetternd. AlphaZero spielt übermenschlich und schlägt alle bekannten Kombinationen aus Programmen und Zentauren. AlphaZero ist der neue König und die Sportarten findet sich in einem Warren Bennis Szenario wieder:

„The factory of the future will have only two employees, a man and a dog. The man will be there to feed the dog. The dog will be there to keep the man from touching the equipment.“

Die Sache hat jedoch glücklicherweise ein Aber: Am Anfang war AlphaZero und das Nichts. Nun blühen Open Source Forks von Alpha Zero auf, wie zum Beispiel Leela Zero, die wie ihr Ursprung Neuronale Netzwerke benutzen, um Go (Leela Zero Go) oder Schach (Leela Chess Zero) zu spielen. Vor kurzem besiegte die Facebook / Carnegie Mellon University KI Pluribus sogar mehrere Spieler beim Pokern.

Irgendwann wird es mehr Projekte dieser Art geben (weil Hardware und Software Anforderungen sinken) und sie werden sich nicht einig sein, welcher Zug in ihrer Umgebung der beste ist. Und an dieser Stelle kommt der Mensch zurück ins Spiel, der wie beim Centaur-Chess zwischen den angebotenen Optionen abwägen kann und die Entscheidung in eine langfristige Strategie integriert oder den Programmen Befehle gibt, sich auf bestimmte Probleme zu fokussieren. Magnus Carlsen, gegenwärtiger Schachweltmeister, zeigt zusätzlich einen zweiten Weg auf: Man kann die neue Kreativität der künstlichen Intelligenz zur Erweiterung der eigenen Kreativität nutzen, indem man Inspiration im Spiel der Maschine sucht.

Algorithmen sind und bleiben Werkzeuge, die, genau wie alle anderen Werkzeuge, überprüft, gewartet und kalibriert werden müssen

Seit geraumer Zeit wird über die horrenden Auswirkungen von Automatisierung und Künstlicher Intelligenz diskutiert. Man kann sich relativ einfach ausmalen, wie AlphaZero abseits von Brett- und Computerspielen eine Industrie nach der anderen verändert. Es winken Produktivitätszuwächse und effiziente Prozesse. Doch die Kehrseite sind radikale sozio-ökonomische Implikationen. Jeder Beruf oder Arbeitsplatz spürt die latente Gefahr, substituiert zu werden.

Auch wenn die Showdowns mit Kasparov, Jennings, Sedol und Jie retrospektiv disruptiv wirken, ist die technologische Entwicklung inkrementell. Wir haben Computer die Schach, Go, Poker oder StarCraft II spielen, Röntgenbilder lesen, das Wetter vorhersagen, mit 100 km/h die Autobahn hinunterfahren, unsere Stimme verstehen, in Dokumenten nach Fehlern suchen, traditionelle Bankarbeit erledigen, buchhalterisch tätig sind, unser Haus wärmen, Spielsucht identifizieren, Anwälten helfen, Fonds verwalten, die günstigsten Flugpreise finden, Aufsichtsratspositionen übernehmen, Aktien handeln, Pakete sortieren oder ein Gesicht in der Menge identifizieren können.

Computer erledigen einige dieser Aufgaben bisweilen selbstverständlich und besser als wir Menschen. Heute beschwert sich niemand mehr, dass der Computer uns Alternativrouten vorschlägt oder günstigere Flüge am Folgetag anbietet. Graduell haben Maschinen das Ruder übernommen und erledigen eine klar definierte Aufgabe über menschlichem Niveau. Somit verschwinden Betätigungsfelder mit jedem Jahr, in denen Menschen eine Rolle gespielt haben. Möchte man es positiv beschreiben, müsste man sagen, dass die Wirkung auf individueller Ebene schicksalsvoll ist und dennoch im universellem Schema der Dinge unausweichlich.

Wenn Künstliche Intelligenz etwas ist, dann eine Aktivierungsschicht, die nicht nur bessere Antworten zu bekannten Fragen liefert. Sie hilft, neue Fragen in bestehenden Datensätzen zu identifizieren und wird dafür künftig auf Stimmen, Bilder und Videos zurückgreifen können. Jede Industrie und jedes Vertikal hat ihre eigenen, einzigartigen Probleme, die durch Machine Learning automatisiert werden können.

Was wir als Mensch in die Waagschale werfen können, ist das komplette Gegenteil der objektiven, rationalen Hyperspezialisierung der künstlichen Intelligenz. AlphaStar zeigte uns, dass je größer das zu bearbeitende Bild ist, je komplexer die Umwelt und das Problem (siehe zum Beispiel die Themenkomplexe Autonome Mobilität oder Krebsforschung), desto wichtiger bleibt der menschliche Einfluss. Wir können allgemein, kreativ und weitreichend mehrere Optionen in die gegenwärtige Problemlösung integrieren und basierend darauf eine Entscheidung fällen, die sich strategisch, langfristig ausspielen wird. Im Gegensatz zu den Maschinen können wir zudem empathisch und achtsam sein, kreativ Probleme lösen und Gemeinschaft pflegen und leben.

Richten wir den Fokus auf die Kollaboration, auf den Zentauren, liegt in der Mensch-Maschinen-Symbiose weiterhin eine große Chance der Zukunft. Künstliche Intelligenzen (mehrere konkurrierende Programme) können Ärzten bei der Diagnose unter die Arme greifen, sodass diese sich auf den Menschen konzentrieren können. Niemand will von einer Maschine behandelt werden, doch haben wir erkannt, dass Maschinen besser darin sind Hautauffälligkeiten zu erkennen. Zudem skalieren sie besser, was man von Experten nicht sagen kann. Ähnliche Entwicklungen sind im Bereich der Bildung (Umgekehrter Unterricht), im Rechtswesen (mehr Kommunikation mit Klienten), im Verkehr (Schaffung eines dritten Lebensraumes), bei der Organisation von Events (einfache automatisierte Terminkoordination), in der Kunst (Erschaffung neuer Welten) oder im Handel (weniger Kassierer, dafür mehr “Concierges” die sich individuell um die

Bedürfnisse ihrer Kunden kümmern) denkbar.

Auch wenn der Ausblick rosig klingen mag, gefährlich ist und bleibt indessen die Entwicklung, dass wir uns von Maschinen abhängig machen, die entwickelt wurden, um die rasant steigende Komplexität der Welt zu managen. Wir dürfen nicht den Fehler begehen und uns in diese Unmündigkeit begeben.

Algorithmen stellen uns heute partiell bereits nur noch die Informationen zur Verfügung, die wir sehen sollen oder verstehen können. Sie übersetzen oder interveniert für uns, so dass wir Menschen uns nicht mehr gegenseitig verstehen müssen. Natürlich stehen auf der möglichen Habenseite viele potenzielle Vorzüge. Dennoch werden wir geschwächt. Denn teilweise verstehen wir gar nicht mehr, wie künstliche neuronale Netzwerke funktionieren. Wir fragen auch nicht nach, wenn das Ergebnis stimmt. Wenn aber zukünftig Intelligenzen vermitteln sollen, wird uns mittelfristig die Fähigkeit abhanden kommen, sich komplexen Problemen selbstständig zu widmen. Künstliche Intelligenzen werden uns das Verständnis nehmen. Sie werden uns den Zugang zur Entscheidungsfindung entziehen und verbieten. Vielleicht bekommen wir noch die Rohdaten. Aber da Algorithmen nicht wie Menschen “denken”, besteht permanent die Gefahr, dass Datenverzerrungen erzeugt oder im Prozess weitergegeben werden. Fehler sind nie

auszuschließen.

Will der Mensch die Kontrolle behalten, muss er die Deutungshoheit bewahren. Denn wenn die Maschine nicht mehr verstanden wird, man ihr jedoch kompromisslos vertraut, überschreiten wir eine verhängnisvolle Schwelle.

Das menschliche Vertrauen in hyperspezialisierte Intelligenzen ist daher extrem bedrohlich. Irgendwann vertrauen wir ihnen Entscheidungen ausserhalb ihrer stabilen und engen Strukturen an. Bevor wir überhaupt nur im Ansatz über eine todbringende “Artificial General Intelligence” mit Bewusstsein sprechen können, wurde das Ende der Menschheit bereits von einer KI mit dem Bewusstsein eines dreijährigen Kindes besiegelt, welche aus Versehen auf den falschen Knopf gedrückt hat.

Es war schon immer wichtig, über den Einsatz und die Wirkung von Künstlicher Intelligenz zu sprechen. Doch gegenwärtig scheint es dringender denn je. Die fast paradigmatischen Ereignisse Kasparov, Jennings, Hui, Sedol und Jie sollten uns eine Warnung sein. Denn die Zukunft verbirgt sich geschickt in der Gegenwart. Noch haben wir die Chance offen über Abhängigkeiten und Vertrauen zu sprechen. Noch können uns Maschinen helfen, Dinge besser zu verstehen. Wir sollten nur nie Künstliche Intelligenzen zwischen uns und unser Verständnis lassen.

Further Reading:

Interessante Perspektive, siehe Beitrag Quantenüberlegenheit:

As Boaz Barak put it to me, the current contest between IBM and Google is analogous to Kasparov versus Deep Blue—except with the world-historic irony that IBM is playing the role of Kasparov! In other words, Kasparov can put up a heroic struggle, during a “transitional period” that lasts a year or two, but the fundamentals of the situation are that he’s toast. If Kasparov had narrowly beaten Deep Blue in 1997, rather than narrowly losing, the whole public narrative would likely have been different (“humanity triumphs over computers after all!”). Yet as Kasparov himself well knew, the very fact that the contest was close meant that, either way, human dominance would soon end for good.

Von Scott Aaronson’s Blog Shtetl-Optimized.

Pocket Guide to Digital Transformation

longthoughts

July 19, 2019

Going to the Moon is no longer a Moonshot

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Die Mondlandung der „Apollo 11“ jährt sich am Wochenende zum fünfzigsten Mal. Ein wahnwitziges Unterfangen, das am 21.07.1969 seinen Höhepunkt feierte. Ein spannendes Detail unter vielen: Der bei den Apollo Missionen eingesetzte Flugcomputer war der erste Computer der Geschichte, der eine Verantwortung für Menschenleben trug. Zeit zurückzuschauen und einen Blick auf damalige und heutige Technologien sowie Moonshots zu werfen, sich zu fragen wie komplex unsere Welt geworden ist, was wir von ihr wirklich verstehen und ob die Zukunft für die Gegenwart bürgen sollte.

Am 25. Mai 1961 verkündete John F. Kennedy, dass sich die USA verpflichten solle, innerhalb einer Dekade einen Mann auf den Mond und wieder zurück zu bringen. Was folgte ist hinlänglich bekannt. Am 21. Juli 1969 um 3:56 Uhr MEZ betraten im Zuge der Mission Apollo 11 die ersten Menschen den Mond.

Auch nach 50 Jahren ist die Apollo Mission ein positives Symbol für den Umgang mit Ungewissheit, Wagnis und Risiko. Niemand war damals von Kennedy überraschter, als die Wissenschaftler und Ingenieure der NASA. Denn niemand wusste wie man eine Rakete baut, die groß genug ist, um den Mond zu erreichen. Niemand wusste, wie man einen Computer baut, der klein und stark genug ist, um ein Raumschiff zu fliegen. Auch wusste niemand, wie die Oberfläche des Mondes aussah, geschweige denn wie Astronauten im Weltraum essen sollten. Amerika hatte im Mai 1961 ganze fünfzehn Minuten Raumfahrterfahrung und nur fünf davon außerhalb der Atmosphäre. Auch in der Sowjetunion fehlte zur damaligen Zeit die Expertise. Die russischen Hunde Strelka und Belka, sowie 40 Mäuse, 2 Ratten und Pflanzen waren die einzigen Lebewesen, die damals sicher in den Weltraum gestartet sind und sicher auf der Erde landeten.

Was in den kommenden Jahren folgte, kann man derzeit überall nachlesen und sehen. Mehr als 400.000 Wissenschaftler, Ingenieure und Fabrikarbeiter arbeiteten 24/7 an 365 Tagen im Jahr, um Neil Armstrong, Michael Collins und Buzz Aldrin am 21. Juli 1969 zum Mond zu bringen.

Abbildung 1: Das Team der Apollo 11 verfolgt den Start im Launch Control Center, Stabilo Werbung

Abbildung 1: Das Team der Apollo 11 verfolgt den Start im Launch Control Center, Stabilo Werbung

Der Wettlauf ins All und der spätere Wettlauf zum Mond führte dazu, dass in vielen Bereichen grundlegende Erkenntnisse gewonnen und Durchbrüche gefeiert wurden. Zehntausende von Problemen wurden gelöst, bevor die unmögliche Mission im Juli 1969 Wirklichkeit wurde. Ohne die Mondlandung gäbe es vielleicht heute keine Computer-Mikrochips, Photovoltaikmodule, GPS oder kein Hubble Weltraumteleskop, keine Gravitationswellen-Observatorien und interplanetare Missionen. Das Leitbild beflügelte Politik, Wissenschaft, Forschung und Technologie über den kalten Krieg hinaus.

Der Apollo-Flugcomputer war der erste Computer der Geschichte, der eine Verantwortung für Menschenleben trug

Eines der zehntausend unmöglichen Unterfangen war die automatische und autonome Weltraumnavigation. Niemand wusste auch nur annähernd, wie man zum Mond navigiert. Geschweige denn, wie man einen Computer baut, der verlässlich ist, möglichst wenig Strom verbraucht, nicht viel Platz einnimmt und einfach zu bedienen ist. Die damaligen Rechner waren so groß wie mehrere Kühlschränke, stürzten häufig ab und mussten über Lochstreifen mit Informationen gefüttert werden.

Deswegen startete man am MIT Instrumentation Laboratory die Entwicklung der Flugsoftware für das Raumfahrtprogramm Apollo 11. Die Forscher entwickelten eine neue, bisher unbekannte Art der Speicherung von Computerprogrammen und schufen eine neue Programmiersprache. Geleitet wurde das Programm von Margaret Hamilton. Mit über 400 Mitarbeitern entwickelte sie in der Software Engineering Division den ca. 40.000 Lines of Code starken Quellcode (andere Quellen nennen 145.000 LOC) für den Apollo Guidance Computer (AGC) - der inzwischen auch auf Github zu finden ist und voller Easter Eggs und Kommentare steckt.

Abbildung 2: Hamilton neben Ausdrucken der Apollo-Flugsoftware, Wikipedia

Abbildung 2: Hamilton neben Ausdrucken der Apollo-Flugsoftware, Wikipedia

Auch wenn der Vergleich mit der Gegenwart hinkt, zeigt er auf, was sich in den letzten 50 Jahren verändert hat: Der Prozessor des AGC lief mit 0.043 MHz und konnte 2048 Datenworte zu 16 bit (also etwa 4 Kilobyte) im Arbeitsspeicher halten. Eine Festplatte gab es nicht, lediglich ein read-only ROM-Speicher von etwa 72 Kilobyte existierte. Alle wichtigen Berechnungen wurde vom Team auf der Erde durchgeführt.

Der Prozessor des neuesten iPhone läuft mit etwa 2490 MHz und weist einen 4 GB RAM Speicher auf. Vier Gigabyte sind 34.359.738.368 Bit. Das ist mehr als eine Million mal mehr Speicher als der Apollo-Computer im RAM hatte. Das iPhone ist mit einem bis zu 512 GB großen ROM-Speicher ausgestattet. Das ist mehr als das Siebenmillionenfache. Hinsichtlich der Rechenleistung sieht es ähnlich aus. Das iPhone verfügt über die einhunderttausendfache Rechenleistung des Computers, der vor 50 Jahren auf dem Mond landete.

Baut man mit dem AGC Bitcoins ab (was wirklich jemand versucht hat), braucht man ca 10,3 Sekunden für einen Bitcoin Hash. Das bedeutet, dass der AGC im heutigen Bitcoin-Netzwerk ungefähr das Alter des Universums multipliziert mit einer Million brauchen würde, um einen einzigen Bitcoin Block erfolgreich abzubauen, der rund 140.000 USD wert ist. Selbst Taschenrechner, Glühbirnen, smarte Toaster, Luftbefeuchter oder Kühlschränke wären ertragreicher. Zumindest könnten sie hunderte, wenn nicht sogar tausende, Mondlandungen parallel organisieren.

In Sachen Lines of Code fallen die Unterschiede ähnlich extrem aus. Jaguar Land Rover geht davon aus, dass autonome Fahrzeuge 1000 Mal mehr Computercode benötigen werden als der Apollo Guidance Computer. Apollo, die von Baidu entwickelte offene Software-Plattform für selbstfahrende Fahrzeuge,ist bereits innerhalb eines Jahres von 165.000 Zeilen Code im Januar 2018 auf 400.000 LOC im Februar 2019 gewachsen.

Zum Vergleich: Die durchschnittliche iPhone-App hat ca. 50.000 Zeilen Code, während Googles gesamte Codebasis mehr als zwei Milliarden Zeilen für alle Dienste umfasst. Im Gegensatz stehen dazu z.B. eine Boeing 787 (8-14M LOC), F35 Kampfjets (24M), Facebook (61M LOC), der Large Hadron Collider (50M LOC) oder ein moderner Ford F150 (150M LOC), die irgendwo zwischen den Extremen liegt.

Abbildung 3: Lines of Code diverser Maschinen

Abbildung 3: Lines of Code diverser Maschinen

Zugegeben, auch der Vergleich ist unpassend. Hardware und Informationsnetzwerke der 1960er sind schwer mit unserer Gegenwart zu vergleichen. Und eigentlich hätte man auch für die AGC LOC Messung die Codes berücksichtigen müssen, die für die Durchführung der Flüge erforderlich waren (z.B. Flug- und Bodensysteme). Dennoch wird deutlich, wie komplex heute alltägliche Anwendungen sind.

Allgemein gilt: Problemlösung mit wenigen Codezeilen schlägt Problemlösung mit vielen Codezeilen. Viele Codezeilen bedeuten oft, dass der eigentliche Code stützenden Code benötigt, der sich nicht direkt auf das zu lösende Problem bezieht, sondern aufgrund des gewählten Mechanismus existiert. Je weniger stützenden Code man im Code hat, desto besser. Auch weil mit jeder Zeile Code Entwickler härter und länger arbeiten müssen, um weiteren komplexeren Code zu implementieren oder diesen zu warten.

Die menschliche Interaktion mit digitalen Daten und Prozessen hat in den vergangenen Jahren um ein Vielfaches zugenommen

Immer häufiger versuchen wir komplizierte Probleme mit komplexen Lösungen - jede Anwendung mit mehr als einer Million Lines of Code und Konnektivität zu anderen Systemen ist komplex - zu bewältigen. Ein Grund dafür - und auch der Grund für viele Codezeilen - ist die Fülle an nahezu kostenlosem Cloudspeicher, ubiquitär verfügbarer Rechenleistung und flächendeckender Bandbreite. Wenn man aus dem Vollen schöpfen kann, braucht es keine Einfachheit, Kreativität oder Eleganz. Warum optimieren, wenn sich alle achtzehn Monate die Anzahl der Transistoren verdoppelt oder man mehr Rechenleistung für weniger Geld bekommt oder ein Machine Learning Algorithmus das eigentliche Problem automatisiert? Warum effiziente und schlanke Websites bauen, wenn man doch so viele schöne GIFs, Videos und Werbungen hat, um adipöse Websites zu bauen? Warum lange mit Partnern oder Wettbewerbern über Systemhoheit und Ökosystemeffizienz streiten, wenn man

seine Komponenten nicht einfach auch mit Sensorik und Konnektivität ausstatten kann? Das Ergebnis sind smarte aber komplexe Autos, mit dutzenden unabhängigen Firmwares, Protokollen, Betriebssystemen, Modulen, Sensoren, ADAS-Systemen und eben unglaublichen 150M Lines of Code.

Tatsächlich ist die Rückkehr zum Mond heute schwieriger als vor 50 Jahren. Zwar hat sich die Technologie dramatisch entwickelt. Doch neben fehlenden finanziellen Mitteln sind insbesondere die Erwartungen an die Mission gestiegen: Die eingesetzten Raumschiffe müssen wiederverwertbar sein und es müssen Standardtechnologien eingesetzt werden (die Rechenleistung des neuen Orion-Raumschiffs beträgt weniger als 500MHz[^Ja, 500Mhz reichen aus, um den Mond zu erreichen und entspannt auf einem Weltraumflughafen auf der Erde zu landen. Das Problem jeder neuen Generation ist Verlässlichkeit, Verfügbarkeit und Robustheit. Folglich setzt die NASA auch lieber auf Altbewährtes, anstatt auf neue ungestüme Technologien.*]), weil man keine Zeit und kein Geld für die Entwicklung neuer Technologien hat. Alles muss verbunden, verknüpft und aus der Ferne steuerbar sein. Auch ist die NASA weniger tolerant gegenüber Gesundheitsrisiken. Zudem

sollen die Raumschiffe bequemer werden, weil die Astronauten zehnmal so lange auf dem Mond und noch länger im Orbit verweilen sollen. Obendrein soll der ganze Spaß natürlich von GoPros aufgenommen und gestreamt werden. Immerhin leben wir im Zeitalter von Youtube, Twitch und Twitter. Was mal ein Moonshot Projekt war, ist heute ein medienwirksames Spektakel.

Durch die zunehmende Verknüpfung der analogen Welt mit der digitalen Sphäre schaffen wir ein immer dichteres Netz aus Information, Akteueren, Schnittstellen und Algorithmen. Unsere Welt - und auch die der NASA - wird immer komplexer und undurchdringlicher

Konnten die Apollo Astronauten der Software von Margaret Hamilton vertrauen? Mit Sicherheit. Millionen von Arbeitsstunden auf der Erde sind für wenige Weltraumstunden erbracht worden. Die “Software” war hardgecoded - d.h. angepasst an die Hardware und die Situation. Der Weltraum ist mit seinen Parametern “relativ” einfach in seiner Umgebungsstruktur beschreibbar und die Navigationsintelligenz musste keine Billionen von Daten verarbeiten, wie es im Stadtverkehr der Fall ist. Der Computer hatte eine Aufgabe und ein Ziel: Die sicherste aller sicheren Reisen zum Mond und wieder zurück zu ermöglichen. Und die Software für das Apollo-Programm war zuverlässig. Während allen Apollo Missionen wurden keine Bugs gefunden und die Software wurde später für den Einsatz in der Weltraumstation Skylab, im Space Shuttle und in

den ersten Fly-by-Wire-Systemen angepasst.

Können gegenwärtige Astronauten und Astronautinnen Software vertrauen? Bestimmt. Die NASA versucht Risiko auf ein Minimum zu reduzieren. Doch können wir den Moonshots unserer Gegenwart vertrauen?

Obwohl wir uns bereits einer gewissen Ohnmacht bewusst sind, gestalten wird immer mehr Räume, Prozesse und Systeme, die so komplex sind, dass sie mittlerweile nur noch von Maschinen und künstlichen Intelligenzen erfasst und verarbeitet werden können. Börsenparkette sind leer, weil das Geld mit autonomem Hochfrequenzhandel in Datencentern erwirtschaftet wird. Die Warenlager von Amazon müssen von einer KI gemanagt werden, weil das eingesetzte chaotische System effizienter als Ordnung ist. In ihnen sind Menschen nur noch als roboterhafte Wesen erlaubt. Der Verkehr der Zukunft soll autonomen, elektrisch angetriebenen Fahrzeugen gehören, die immer dann dort stehen, wo wir sie brauchen, optimal vernetzt und gesteuert von einer künstlichen Intelligenz.

Abbildung 4: Ein gefangenes selbstfahrendes Auto, James Bridle

Abbildung 4: Ein gefangenes selbstfahrendes Auto, James Bridle

Zwar werden im Bereich der autonomen Mobilität und auch in anderen Bereichen die Forschungsinitiativen von Tag zu Tag ehrgeiziger und ambitionierter. Allerdings ist unsere Umwelt keine Mikrowelt, deren Komplexität, Dynamik und Undurchsichtigkeit beschreibbar ist. Milliarden von vernetzten Variablen treffen in unserer Welt auf Millionen von Dynamiken. Beginnt man einmal die Ausnahme der Ausnahme zu beschreiben, endet man im Chaos. Es wird noch Jahrzehnte dauern und hunderte Milliarden US Dollar kosten, bis man allein nur das Problem “intelligenter Verkehr” gelöst hat.

Die Zukunft sollte sich nicht für die Gegenwart verbürgen

Apollo 11 hat es nur zum Mond und wieder zurück geschafft, weil die NASA alle damals denkbaren Szenarien simulierte, um das Risiko eines Fehlversuches so gering wie möglich zu halten. Und auch heute wird bei der NASA alles getan, um denkbare wie undenkbare Szenarien mit in die Planung einzubeziehen. Das oberste Gebot ist der Schutz der Besatzung.

Man kann sich nur wünschen, dass Technologieunternehmen ähnlich vorgehen. Vor allem dann, wenn Menschenleben auf dem Spiel stehen. Doch das scheint eine Illusion. Nur wenige Produkte werden auf Herz und Nieren getestet oder so entwickelt, dass sie nahezu fehlferfrei sind. Wenn das große Geld winkt und es darum geht, schneller als alle anderen zu wachsen, heißt es nur noch: Fake it, until you make it. Gepatcht wird danach.

Der Glaube an die zukünftige Macht von Künstlicher Intelligenz und Automatisierung ist so stark, dass selbst Misserfolge und fatale Unglücke die Begeisterung nicht bremsen können. Unfälle, wie der Absturz des Lion-Air-Fluges 610, bei dem der Pilot absolut keine Ahnung hatte, was das Bordsystem von ihm wollte, werden als singuläres und überwindbares Problem abgetan. Spätestens mit dem nächsten OTA Update kommt eine Lösung. In diesem abstrakten Zukunftsvertrauen, dass rosige Zukünfte alles entschuldigen, schwelt einer der größten Gefahren unserer Zeit. Reibungslose Zukunftsbilder schwindeln uns vor, dass die Probleme der Gegenwart künftig mit ein paar Zeilen Code überwunden werden können: Es ist OK etwas unfertiges am Markt zu platzieren. Es ist OK Algorithmen entscheiden zu lassen, auch wenn wir nicht verstehen

wie sie funktionieren oder Entscheidungen treffen. Lasst uns lieber den Mantel des Schweigens über die Komplexität der Realität werfen und Ungewissheiten bewusst maskieren.

Wir sollten uns nicht von hochgejazzten Potentialen und Chancen blenden lassen, die Unternehmen für den Produktverkauf produzieren. Die Welt befindet sich im stetigen Wandel. Die Zukunft ist tief, facettenreich, vage und verankert in einer komplexen Gegenwart. Heute mehr als gestern. Durch das Erkennen des Notwendigen, Möglichen und Gewollten können wir sie gestalten. Da sich die zukunftsfixierten Visionäre unserer Zeit nicht gern erinnern, sollten wir das tun. Wir müssen deswegen mehr über Risiken, Ungewissheiten, Relevanz und Implikationen von gegenwärtigen und vergangenen Moonshots diskutieren. Nur so können wir aus vergangenen Fehlern lernen und positive wie negative Implikationen antizipieren. Und nur so können wir gemeinsam die Geschichte der Zukunft neu definieren.

Pocket Guide to Digital Transformation

mediumthoughts

June 28, 2019

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Vor knapp 15 Jahren waren die Top 10 Dax-Werte neun Mal soviel wert wie die 10 größten globalen Plattformen zusammen. Ende 2018 sieht das Bild anders aus: Plattformen sind bereits drei Mal soviel Wert wie die Top 10 Dax-Werte.

Abbildung 1: Entwicklung der Marktkapitalisierung, DAX versus Plattformunternehmen, 2000 - 2019, volle Infographik hier

Abbildung 1: Entwicklung der Marktkapitalisierung, DAX versus Plattformunternehmen, 2000 - 2019, volle Infographik hier

Der Erfolg von Google, Apple, Facebook, Amazon, Tencent oder Alibaba ist offensichtlich eng verwoben mit der Internetrevolution. Vor 20 Jahren konnten sich knapp 100 Millionen Menschen einen Zugang zum Internet leisten. Heute sind bereits 51 Prozent der Menschheit mit dem Internet verbunden und interagieren mit 4 Milliarden aktiven Smartphones. 900 Millionen iPhones treffen auf 3,1 Milliarden Androidgeräte verschiedener Hersteller.

Keiner zweifelt mehr an der technologischen Leistungsfähigkeit, an der Breite potentieller Einsatzgebiete oder an der Dominanz von Apple und Google. Smartphones sind zu der wichtigsten Infrastruktur unseres Zeitalters geworden, auf der alle anderen erfolgreichen Digitalunternehmen wie Facebook (2,3 Mrd. monatlich aktive Nutzer), Uber (91 MAU), Netflix (150 Millionen zahlende Nutzer), Spotify (100 Millionen zahlende Nutzer) oder ByteDance (mehr als 1 Milliarde MAU im Portfolio, bestehend u.a. aus Toutiao, TikTok/Douyin und FaceU) aufsetzen.

Diese Unternehmen sind zu einem festen Bestandteil unser digitalen Lebenswelt geworden. Ein Blick auf den eigenen Homescreen genügt. Anwendungen von Google, Apple oder Facebook (Messenger, WhatsApp, Instagram und zukünftig wahrscheinlich auch Libra) dominieren. Aber auch die Apps von Amazon, Spotify, Twitter, Snapchat oder Netflix fühlen sich hier zu Hause. Jedes Mal wenn wir das Smartphone einschalten — im Durchschnitt 60 mal pro Tag — gieren die Anwendungen nach unserer Aufmerksamkeit. Im Gegenzug erhalten wir glücklich machende Dopamin-Shots. Jeder Like, jeder Einkauf, jeder Entertainment Konsum gleicht einem Kick guter Laune.

Der Lohn? Egal ob man Marktkapitalisierung oder Markenwert als Indikator für wirtschaftlichen Erfolg anlegt, Plattformen gewinnen. Sie sind die Pförtner der wichtigsten Ökosysteme dieser Welt. Sie orchestrieren eine neue Art der Wertschöpfung und richten sie konsequent auf den Kunden und seine Bedürfnisse aus.

Vor allem verbraucherorientierte Branchen haben die Macht der mobilen Endgeräte mit ihren globalen Entwicklerökosystemen und länderübergreifenden Anwendungsmarktplätzen in der Vergangenheit zu spüren bekommen. Wertschöpfung, Kundenzufriedenheit, Kundenanspruch und Kundenzugang wurden in zahlreichen Branchen neu ausgehandelt. Kaum eine Branche ist heute nicht betroffen. Alle diskutieren über Disruptoren, Plattformstrategien, Technologieplattformen oder plattformbasierte Geschäftsmodelle. Der digitale Wandel wurde eingeleitet und scheint nicht mehr aufzuhalten zu sein.

Das Problem?

Die Plattform Ökonomie wird von amerikanischen und chinesischen Unternehmen sowie Risikokapitalgebern aus diesen Ländern dominiert. Spotify ist die einzige europäische Plattform von globalem Format. Europa wurde vom digitalen Wandel überrannt und agiert deswegen zunehmend aus der Defensive. Egal wo man hinschaut herrscht Unruhe und Ungewissheit. Die Deutsche Bank ist ein Schatten seiner selbst, die einstmals großen deutschen Energiekonzerne sind auf Tauchgang, Thyssenkrupp sucht eine Identität und Bayer schluckt schwer an der Monsanto Integration. Die europäischen Autokonzerne schauen alle auf sich, obwohl sie wissen, dass Connected und Smart Mobility nur gemeinsam bewältigt werden kann. Ohne eine diskriminierungsfreihe Datenplattform, welche Austausch und Harmonisierung ermöglicht, keine autonomen Autos die miteinander kommunizieren und keine service-getriebene Ökonomie. Kein Konsument hat Lust auf 15 individuelle Mobility Apps für jede europäischer Großstadt.

Zugegeben, die Zeiten sind so unsicher wie nie. Neue (digitale) Technologien entstehen am laufenden Band. Die politische Lage ist für global agierende Unternehmen komplexer denn je, der Aktienmarkt fordert Gewinne und der Druck zu innovieren ist stärker als nie zuvor. Die komplexe und ungewisse Realität macht vor allem den Unternehmen zu schaffen, die zuvor eine über Jahre dominierende Rolle innehatten. Sie konnten bestimmen und der Markt folgte. Die Pfade schienen definiert und die Zukunft war zu plus minus 5% prognostizierbar. Das Geschäftsmodell war linear, die Hierarchie klar definiert, Innovation war eine Frage von Patenten und die Strategie war sowieso perfekt, weil man die besten Produkte im Markt hatte. Doch die alten Gewissheiten gelten nicht mehr. Die schöne neue Welt macht alles anders.

Stark bemängeln muss man daher die fehlende Offenheit der letzten Jahre gegenüber Ungewissheiten und den fehlenden Mut neues auszuprobieren. Die Plattform Ökonomie ist eine Revolution des Geschäftsmodells. Außer SAP hat kein DAX Unternehmen nennenswert auf dieses Modell gesetzt oder Mitarbeitern die Freiheit gegeben Experimente zu starten. Der Fokus liegt auf interner Effizienz, linearen Prozessen und guten Produkten. Nicht auf gemeinsamer Wertschöpfung im Ökosystem oder auf gemeinsam-getriebenen Innovationen. Europa und im besonderen Deutschland hat die IT Revolution kommen sehen und beschlossen sie auszusitzen. Das aber nach einer Welle oftmals weitere und auch größere Wellen folgen, ist nun zu einem echten Problem geworden.

Was kommt als nächstes?

Der Hunger der Plattformen nach Wachstum ist weiterhin ungestillt. Sie expandieren in angrenzende Märkte, erweitern ihr Angebot durch neue Anwendungen oder integrieren vertikal ihre eigene Lieferkette, um mehr Kontrolle über das Angebot auf der Plattform zu erhalten oder um die Ausgaben für klassische primäre und unterstützende Aktivitäten zu reduzieren. Airbnb baut zum Beispiel eigene Hotels, um ihren Kunden eine bessere integrierte “Experience” im Digitalen wie im Analogen zu bieten. Amazon verkauft nicht mehr nur Alles und Cloud-Services, sondern entwickelt unter hohem Kapitaleinsatz ein neues Betriebssystem für den modernen Einzelhandel und optimiert damit gleichzeitig die eigene Logistik und Intralogistik. Amazon Prime und Netflix investieren pro Jahr zweistellige Milliardenbeträge in eigenen Content und Lizenzen, die neue Kunden anlocken, diese aber auch auf der Entertainment Plattform halten soll. Spotify investiert in ein Musikwiedergabegerät für das Auto. Google, Facebook

und Amazon investieren in Seekabelinfrastrukturen, um die Performance ihrer Rechenzentren zu optimieren, aber auch um afrikanische und südamerikanische Märkte zu erschließen.

Der Kampf um digitale Märkte hat damit ein neues physisches Level erreicht. Die Digitalen haben erkannt, dass Asset-light Plattformen der erste Schritt zu noch größeren Märkten waren. Denn selbst „disruptierte“ Branchen stecken immer noch in den Kinderschuhen des digitalen Wandels: Der globale Einzelhandel beläuft sich zum Beispiel auf circa 25 Billionen Dollar pro Jahr. Der E-Commerce-Anteil am gesamten globalen Einzelhandelsumsatz betrug 2017 aber nur knapp mehr als 10 Prozent. Ein anderes Beispiel: Nach Angaben von Zalando ist der Fashion Markt in Europa 420 Milliarden Euro groß. Und daran hält Zalando gerade mal 1,2 Prozent. Das langfristige Ziel sind ambitionierte 5 Prozent.

Dieser Gangwechsel sollte von allen tradierten Unternehmen als Chance begriffen werden. Es wird zukünftig nicht mehr darum gehen Software oder Internettechnologien zu nutzen, um Kundenerlebnisse, Einkaufsprozesse oder internen Verwaltungsaufwand durch kapitalschwache service-getriebene Plattformansätze zu optimieren. Es wird darum gehen, die materielle mit der immateriellen Welt zu verschmelzen, um Prozesse in der analogen Welt effizienter und effektiver zu machen. Je mehr Materie dabei eine Rollen spielt, desto größer der Hebel traditioneller Unternehmen und Industrien.

Zugegeben, die großen amerikanischen Digitalunternehmen besitzen eine Datenkompetenz, die schwer abzufangen ist. Der Anteil deutscher Unternehmen an der Plattform Ökonomie liegt zudem maximal im unteren einstelligen Bereich. Doch das kann und sollte sich ändern. Initiativen wie Mindsphere von Siemens, die Daimler und BMW Mobility Service Fusion, Wirecard, die deutsche Aftermarket Branchenlösung Caruso, Aviatar von Lufthansa Technik, Chemondis von Lanxess, XOM Materials von Klöckner oder Axoom von Trumpf zeigen, dass auch deutsche Unternehmen innovativ auf Plattformen und Ökosysteme setzen können.

Auf der Innovationsagenda von Unternehmen sind immer häufiger plattform-getriebene Geschäftsmodelle zu finden. Sie verdrängen in der Strategie die Digitalisierung und Sensorfizierung bestehender Assets und Prozesse. Natürlich war letzteres zwingend notwendig. Man sollte sich aber nicht darauf ausruhen. Jetzt gilt es die Geschäftsmodelle anzupassen, zu schauen, wie man gemeinsam Plattformen initiiert, um alle anfallenden Daten auch zweckgebunden zu verarbeiten.

Zurück zu den Ursprüngen?

Digitale Wertschöpfung folgt anderen Regeln und Dynamiken. Einer der wichtigsten zu falsifizierenden Hypothesen ist daher die Frage, ob Daten der wichtigste Rohstoff der neuen Welt sind.

Die oben gezeigten Plattformunternehmen stehen auch deswegen dort, weil sie Zugang zu umfangreichen Datenquellen besitzen und massiv interne Analytik-Expertise aufgebaut haben. Sie haben erkannt, dass Produkte durch Daten besser werden und Analytik unerlässlich dafür ist. Sie haben nicht nur Kapazitäten intern aufgebaut (und diese teilweise in Europa eingekauft), sondern ihre Systeme so gestaltet, dass sie konsequent Daten generieren. Sie sind die alleinigen Nutznießer ihrer Daten.

Leider hat diese selbstverstärkende Entwicklung dazu geführt, dass aus dem ehemals dezentralisiertem und offenem Internet mehrere geschlossene, abgekapselte und monetarisierte Räume wurden. Diese Räume sind tief in unserer Alltagswelt verwurzelt und formen unsere Lebenswelt. Es ist daher zwingend notwendig, sich über Regulation, Datenhoheit und Netzwerkkontrolle auszutauschen. Auch, weil die allgemeine Wertschöpfung bereits abgewandert ist, da amerikanische und chinesische Digitalakteuere in grundlegenden Bereichen wie der Mobilität oder der Kommunikation führend sind.

Kommt die Regulierungsdiskussion daher zur rechten Zeit? Unbedingt, wenn nicht sogar zu spät. China hat sich während der IT Revolution abgekapselt und einen Plan entwickelt der aufgeht. Europa tut deswegen gut daran, die begonnenen Debatten mit aller Härte zu führen. Allerdings sollten diese nicht auf dem Rücken der Gesellschaft ausgefochten werden und nur spezifischen Lobbies zu Gute kommen.

Auch sollten europäische und deutsche Unternehmen sich langfristigen ökosystem-basierter Innovation öffnen. Gerade wenn wir annehmen, dass Daten ein Schlüssel zu besseren Services und Produkten sind, liegt in der unternehmensübergreifenden Kollaboration eine immense Chance. Gemeinsame Datenpools oder Datenplattformen sind der Schlüssel zu Themen wie Smart Mobility, Smart Logistics, Smart Health und anderen Vertikalen. Wir alle kennen mittlerweile unzählige Anwendungen in diesen Bereichen. Doch es fehlt eine gemeinsame Infrastruktur, auf der Services und Produkte entwickelt werden können. Nur wenn Branchen sich auf Datenplattformen einigen, können Kapazitäten gemeinsam organisiert werden. Nur so können systemische Effizienzen allen zugute kommen.

Von großem Vorteil ist, dass tradierte Unternehmen auf außerordentlichen Rohstoffquellen sitzen. So können zum Beispiel allein die Automobilhersteller auf Zettabytes von In-Car Daten zugreifen. Doch ohne eine gemeinsame Verarbeitung kein intelligenter Verkehr oder geteilte Mobilitätsservices. Die Digitalunternehmen haben sich dementsprechend positioniert. Sie versuchen vor allem das Konsumenteninterface zu besetzen, um Nutzern den Zugang zu ihren Ökosystemen möglichst bequem zu gestalten. Darüber hinaus haben sie vielversprechende datengenerierende Experimente im Bereich selbstlenkende Vehikel gestartet und drängen zunehmend tief in die Autos vor, indem sie mit den Non-Premium Marken Kooperationen eingehen. Das Problem? Sobald die Daten an ihre Ökosysteme angeschlossen werden, bleiben sie in den Ökosystemen.

Aus diesem Grund sind Blockchain oder vergleichbare Ansätze von Interesse. Sie sind der vielversprechenste Weg, um aus den geschlossenen Räumen, die wir Internet nennen, wieder offene, mit einander verbundene Räume zu machen. Zwar wurde das Thema in den vergangen Jahren stark vom Hype getragen. Langfristig hat die Technologie aber das Potenzial vieles zu verändern. Sie könnte die digitale Welt neu ordnen, in dem sie Unternehmen, Privatpersonen und Maschinen die Möglichkeit gibt souverän, diskriminierungsfrei und kontrolliert mit Daten in einem geteiltem Ökosystem umzugehen.

Blockchain Innovationen werden in den kommenden Jahren hoffentlich dazu führen, dass Daten nicht nur intern (auch wenn das schon viele Unternehmen vor Probleme stellt), sondern auch extern mit Partnern und sogar Wettbewerben geteilt werden. Unternehmen könnten sich in einem Ökosystem zusammenschließen und äquivalente Angebote zu Plattformen schaffen, ohne dass ein einziges Unternehmen 99% der gesamten Wertschöpfung einstreicht. Bereits heute arbeiten Startups an dezentralen Lösungen für Computing, Storage und Kommunikation. Innovation in diesem Bereich würden dabei helfen, endlich große und relevante Datenpools zu schaffen. Denn ohne zweckgebundene Daten, keine datengestützte Wertschöpfung.

Mut zur eigenen Zukunft

Das Internet war einmal ein diffuser Ort der Offenheit, der Kreativität und des Austausches. Alles wurde geteilt. Alles war neu und experimentell. Heute ist unser Internet das cleane und auf Hochglanz polierte Intranet von Google, Apple, Facebook, Amazon, Microsoft. Nur wenn wir es schaffen, den frühen Gründergeist wieder aufleben zu lassen, gemeinsam an einem Strang zu ziehen und dabei Infrastrukturen und Geschäftsmodelle entwickeln, die allen helfen zu partizipieren, kann das Monopol der großen Digitalunternehmen aufgebrochen werden.

Hier liegt die große Chance aller Unternehmen, die sich abgehängt fühlen. Nur wenn man gemeinsam die großen Themen unserer Zeit angeht, können und werden Lösungen entstehen, die mindestens gleichwertig, wenn nicht sogar besser als die Lösungen der Unternehmen sind, die heute den Ton angeben. Auch, weil die Rohstoffquellen für die Themen der nächsten Jahre noch in der Hand von tradierten Unternehmen liegen. Es fehlt einfach ein bisschen Mut, sich eine eigene Zukunft zu schaffen.

Pocket Guide to Digital Transformation

mediumthoughts

June 17, 2019

Die Entdeckung von Big Data Analytics im 19ten Jahrhundert durch den Pfadfinder der Meere

Pocket Guide to Digital Transformation - Reflexionen zu strukturellen Veränderungen, digitalen Konzepten und internetökonomischen Zukunftsperspektiven.

Matthew Fontaine Maury wurde schon zu Lebzeiten als Pfadfinder der Meere bezeichnet. Durch seine Pionierarbeit im Verarbeiten von großen Datenmengen - der Aufbereitung von Millionen von historischen Navigationsdaten inklusive intelligenter (analoger) Mustererkennung - ist er nicht nur zum Gründungsvater der Ozeanographie geworden. Er hat es innerhalb weniger Jahre auch geschafft, einer ganzen Industrie mehrere Millionen US-Dollar pro Jahr durch intelligente Datenanalysen zu sparen und Segelrouten zu definieren, die selbst 175 Jahre später noch modern sind.

Von New York nach San Francisco in nur einundachtzig Tagen

1854 gelang der Flying Cloud, einem Fracht-Segelschiff der Klipper Klasse, etwas Unvorstellbares. Sie stellte einen Segelweltrekord für die schnellste Passage zwischen New York und San Francisco auf, der über 130 Jahre Bestand hatte. In 89 Tagen und 8 Stunden umrundete sie unter dem Kommando von Kapitän Josiah Perkins Cressey das Kap Horn und legte mehr als 16.000 Seemeilen in unter dreizehn Wochen zurück. Ein Rekord, der bis ins Jahr 1989 hielt. Eine außergewöhnliche Leistung, wenn man bedenkt, dass zur damaligen Zeit, in den frühen Tagen des kalifornischen Goldrausches, Schiffe mehr als zweihundert anstrengende Tage für die Passage benötigten.

Abbildung 1: Der amerikanische Klipper Flying Cloud in einem Sturm vor Kap Horn, James E. Buttersworth, 1854, Wikipedia

Abbildung 1: Der amerikanische Klipper Flying Cloud in einem Sturm vor Kap Horn, James E. Buttersworth, 1854, Wikipedia

Für diesen erstaunlichen Quantensprung gab es mehrere Gründe. Zunächst benötigt es natürlich ein tadelloses Schiff der neuesten Generation. Ein brillantes Werk der damaligen Zeit, ausgedacht und entwickelt von Donald McKay). Zudem müssen die außergewöhnliche Fähigkeiten der Navigatorin Eleanor Creesy hervorgehoben werden, die bereits einen ersten Passagenrekord im Jahre 1851 mit der Flying Cloud aufstellte und den Ewigrekord in 1854 ebenfalls anleitete. Den größten Beitrag lieferten aber die ersten globalen Wind- und Strömungskarten mit dem klangvollen Namen “Wind and Current Chart of the North Atlantic, Sailing Directions and Physical Geography of the Seas and Its Meteorology” des amerikanischen Marineoffiziers und Ozeanographen Matthew Fontaine Maury.

Matthew Fontaine Maury - Der Pfadfinder der See

Matthew Fontaine Maury war der erste, der die Zirkulation von Winden, Meeresströmungen und Bewegungen des Meeresbodens zu allen Jahreszeiten untersucht, erhoben und verarbeitet hat. Auf seinen Vorschlag hin wurde ab 1847 mit meteorologischen Beobachtungen auf fast allen Schiffen der US Marine begonnen. Zudem veröffentlichte er 1854 die erste Tiefenkarte des Nordatlantiks und 1855 sein bahnbrechendes Werk “The Physical Geography of the Sea”, welches als erste Beschreibung der physikalischen Ozeanographie gilt und auf der Sammlung von 1,2 Millionen Datenpunkten beruht. Durch sein Werk erhielt er den Spitznamen “Pathfinder of the Seas” und wird heute zudem als Vater der modernen Ozeanographie und Marinemeteorologie bezeichnet.

Abbildung 2: Matthew Fontaine Maury, 1855, Wikipedia

Abbildung 2: Matthew Fontaine Maury, 1855, Wikipedia

Maury begann sein berufliches Leben in der Marine als Fähnrich an Bord des Kriegsschiffes USS Brandywine. Im Alter von 33 Jahren brach er sich bei einem Postkutschenunfall das Bein und zog sich eine lähmende Verletzung zu, sodass professionelle Seereisen für ihn nicht mehr in Frage kamen. Das Glück im Unglück versetzte ihn folgend an einen Schreibtisch im Karten und Instrumente Depot des United States Naval Observatory. Dort fand er Räume vor, die bis zum Bersten gefüllt waren. Muffige Kisten, mit salzwasserbefleckten Büchern, Protokollen, verstaubten Karten und Dokumenten, welche bis ins Jahr 1776 zurückreichten, stapelten sich bis zur Decke. Von seinen Vorgängern geflissentlich mißachtet, studierte der neue Leiter des U.S. Navy Head of Depot of Charts and Instruments fortan Tausende von vergilbten Logbüchern und Karten von Schiffen, mit Aufzeichnungen über Oberflächenwinde, Strömungen, Wasser und Wetter an bestimmten Orten zu allen Jahreszeiten.

Wie Maury im 19. Jahrhundert zum Entdecker von Big Data Analytics und datengetriebenen Services wurde

Das Ziel von Maury war es, Seemannschaften bessere und nützliche Informationen zu liefern. Er war fasziniert von den Routen, die Schiffskapitäne bei der Navigation auf hoher See wählten. Oftmals schienen es indirekte, zufällige und ineffiziente Routen zu sein. Er war überzeugt, dass es bessere Optionen geben müsse. Aber es gab keine Möglichkeit, Schiffskapitäne, die sich schon immer auf Traditionen und anekdotischen Geschichten über gefährliche Gewässer stützten, davon zu überzeugen, dass es alternative und effizientere Optionen gäbe. Also organisierte sein Büro vorhandene Informationen, extrahierte Insights und entwickelte ein datengenerierendes Meldesystem für Schiffe, um weitere Informationen über Seegänge und Wetter zu sammeln. So konnte man ein klimatisches Bild der Oberflächenwinde und -ströme aller Ozeane und bestmögliche Ozeanwege für vorbeifahrende Schiffe auf See entwickeln und Maury wurde zu einem der ersten großen Datenpioniere der Welt.

Abbildung 3: Die physische Geographie des Meeres, British Library

Abbildung 3: Die physische Geographie des Meeres, British Library

Maury kann als Urvater der Big-Data-Analyse und sogar als Vorläufer von Google bezeichnet werden. Er nahm öffentliches vorhandenes Material, das wertlos schien, extrahierte Informationen und verwandelte sie in außergewöhnlich nützliche Daten. Er hatte verstanden, dass ein besonderer Wert in großen Datenmengen liegen kann, der in kleineren Datenmengen häufig nicht zu finden ist. Er sah, dass die Protokolle, wenn sie zusammengestellt und analysiert wurden, Wissen enthielten, welches Handelsrouten grundlegend reformieren und Transportzeiten drastisch verkürzen kann. Er verwendete mehrere Datenpunkte, um seine Schlussfolgerungen zu sammeln und zu validieren. Er kombinierte die Daten von Meeresströmungen, Winden und Schiffspositionen, um Muster zu bestimmen, und konnte, basierend auf Analysen, Seeleute auf schnelleren und weitaus weniger gefährlichen Routen beraten.

Datengetriebene Wertschöpfung im 19ten Jahrhundert

Mit dem Versprechen auf diese enormen wirtschaftlichen Gewinne erfuhren die gesammelten und verarbeiteten Informationen plötzlich einen ganz neuen, bisher unvorhersehbaren Wert. Das Team um Maury entwickelte gut definierte Navigationsrouten, die dominierenden Windverhältnissen folgten. Die Reise von New York nach Rio de Janeiro konnte zum Beispiel um 32 Tage reduziert werden, nur indem man vorherrschenden Winde und Meeresströmungen besser ausnutzte. Maury konnte auch zeigen, dass die Nutzung der längeren ostwärts gerichteten Segelroute um Kap Horn herum tatsächlich schneller war als die kürzere westlich gerichtete Segelroute um das Kap der Guten Hoffnung, wenn man von Australien nach Europa oder Nordamerika segeln wollte. Schon sieben Jahre nach der ersten Publikation sparten Maurys “Sailing Directions” den Schiffsflotten weltweit ca. 10 Millionen US-Dollar pro Jahr ein.

Abbildung 4: Wind- und Strömungskarte, Matthew Fontaine Maury

Abbildung 4: Wind- und Strömungskarte, Matthew Fontaine Maury

Maury nutzte seine Position in der Marine ebenfalls dazu, um einen Log Standard zu schaffen. Er bestand darauf, dass alle Schiffe der US Navy Protokolldaten in einem standardisierten Format übermittelten. Auch konnte er die Hilfe von Handelsschiffen in Anspruch nehmen, die ihre eigenen Daten zum Wohle aller teilen wollten. Ein frühes Beispiel für ein datengetriebenes Netzwerk, welches von einem Orchestrator auf eine gemeinsame Wertschöpfung ausgerichtet wurde. Indem Maury sich auf das Problem konzentrierte, wie man effizienter durch die Meere navigieren konnte, war er in der Lage, bereits existierende Daten zu nutzen, um Hypothesen zu testen und neue Werte für existierende Teilnehmer und neue Unternehmen zu gewinnen. Er war in der Lage, die Daten zu verfeinern, die Datengenauigkeit über Datenintegration zu erhöhen und die Daten für eine breite Reihe von Problemen und Anwendungen zu

nutzen. Dazu gehörte u.a. die Bestimmung des Kurses für das erste transatlantische Telegrafenkabel entlang einer flachen Ebene zwischen Irland und Kanada im Jahre 1858. Oder die Nachzeichnung des Kurses der Neptunumlaufbahn nach der Planetenentdeckung im Jahre 1846. Oder eben das Möglichmachen des Weltrekordes der Flying Cloud, weil Eleanor Creesy, die Navigatorin des Schiffes, zu den ersten gehörte, die Maurys Karten verwendete.

Zurück zu den Anfängen: Smarte Analysen und Problemlösungen statt fruchtloser Datengenerierung und Datenhortung

Obwohl Segelschiffe gegenwärtig kaum noch zum globalen Handel oder Tourismus beitragen und damit nahezu von den Weltmeeren verschwunden sind, werden die von Maury entwickelten Routen noch heute von Schiffen auf der ganzen Welt genutzt. Das Beispiel zeigt, dass smarte und intelligente Problemanalysen allen Big Data Versuchen überlegen sind, die versuchen die Gesamtheit aller verfügbaren Daten zu sammeln und dann auf zufällige algorithmische Epiphanien hoffen. Erst existierende Datensätze in Kombination mit spezifischen Fragen, die vielleicht sogar bereits mit den bestehenden Datensätzen beantwortet werden können, ermöglichen Hypothesen, welche durch neue Daten getestet und validiert werden können. Es geht nicht darum Daten anzuhäufen, sondern darum die richtigen Fragen kreativ zu stellen. Wenn dann noch ein Mehrwert für alle Beteiligten gegeben ist, können Innovationen entstehen, die nachhaltig über Jahrhunderte wirken und ganze Branchen verändern.

Pocket Guide to Digital Transformation

mediumthoughts

Abbildung 1: Das Team der Apollo 11 verfolgt den Start im Launch Control Center, Stabilo Werbung

Abbildung 1: Das Team der Apollo 11 verfolgt den Start im Launch Control Center, Stabilo Werbung Abbildung 2: Hamilton neben Ausdrucken der Apollo-Flugsoftware, Wikipedia

Abbildung 2: Hamilton neben Ausdrucken der Apollo-Flugsoftware, Wikipedia Abbildung 3: Lines of Code diverser Maschinen

Abbildung 3: Lines of Code diverser Maschinen Abbildung 4: Ein gefangenes selbstfahrendes Auto, James Bridle

Abbildung 4: Ein gefangenes selbstfahrendes Auto, James Bridle Abbildung 1: Entwicklung der Marktkapitalisierung,

Abbildung 1: Entwicklung der Marktkapitalisierung,  Abbildung 1: Der amerikanische Klipper Flying Cloud in einem Sturm vor Kap Horn, James E. Buttersworth, 1854, Wikipedia

Abbildung 1: Der amerikanische Klipper Flying Cloud in einem Sturm vor Kap Horn, James E. Buttersworth, 1854, Wikipedia Abbildung 2: Matthew Fontaine Maury, 1855, Wikipedia

Abbildung 2: Matthew Fontaine Maury, 1855, Wikipedia Abbildung 3: Die physische Geographie des Meeres, British Library

Abbildung 3: Die physische Geographie des Meeres, British Library Abbildung 4: Wind- und Strömungskarte, Matthew Fontaine Maury

Abbildung 4: Wind- und Strömungskarte, Matthew Fontaine Maury